title: CNN

tags: DL

深度学习以数据的原始形态(raw data)作为算法的输入,经过算法的层层抽象,将原始数据逐层抽象为自身任务所需的最终特种表示,最后以特征到任务的目标的映射(mapping)作为结束,从原始数据到最终任务目标,一气呵成而中间并无夹杂任何人为操作。相比于传统的 ML 算法仅学得模型这一单一任务模块而言,DL 除了模型学习,还有特征学习、特征抽象等任务模块的参与,借助多层任务模块完成最终的学习任务。

神经网络基础概念

神经网络的工作原理

神经网络中每层对输入数据所做的具体操作保存在该层的权重( weight)中,其本质是一串数字。用术语来说,每层实现的变换由其权重来参数化( parameterize)。权重有时也被称为该层的参数( parameter)。在这种语境下,学习的意思是为神经网络的所有层找到一组权重值,使得该网络能够将每个示例输入与其目标正确地一一对应。

一个深度神经网络可能包含数千万个参数。找到所有参数的正确取值可能是一项非常艰巨的任务,特别是考虑到修改某个参数值将会影响其他所有参数的行为。

损失函数(loss function)

想要控制神经网络的输出,就需要能够衡量该输出与预期值之间的距离。这是神经网络损失函数( loss function)的任务,该函数也叫目标函数( objective function)。损失函数的输入是网络预测值与真实目标值(即希望网络输出的结果),然后计算一个距离值,衡量该网络在这个示例上的效果好坏。简而言之,损失函数用于网络如何衡量在训练数据上的性能,即网络如何朝着正确的方向前进。在训练过程中需要将其最小化。它能够衡量当前任务是否已成功完成。

优化器(optimizer)

深度学习的基本技巧是:利用之前的距离值作为反馈信号来对权重值进行微调(fine tuning),以降低当前示例对应的损失值。这种调节由优化器( optimizer)来完成,它实现了所谓的反向传播( backpropagation)算法,这是深度学习的核心算法。其基于训练数据和损失函数来更新网络的机制。决定如何基于损失函数对网络进行更新。它执行的是随机梯度下降( SGD)的某个变体。

神经网络的组件

神经网络的核心组件是层( layer),它是一种数据处理模块,可以将它看成数据 filter 。进去一些数据,出来的数据变得更加有用。具体来说,层从输入数据中提取表示。大多数深度学习都是将简单的层链接起来,从而实现渐进式的数据蒸馏( data distillation)。深度学习模型就像是数据处理的筛子,包含一系列越来越精细的数据 filter (即层)。有些层是无状态的,但大多数的层是有状态的,即层的权重。权重是利用随机梯度下降学到的一个或多个张量,其中包含网络的知识。

神经网络的数据表示

张量的核心在于,它是一个数据容器。它包含的数据几乎总是数值数据,因此它是数字的容器。

张量的关键属性有以下三个关键属性来定义:

- 轴的个数(阶)

- 形状,它是一个整数元祖,表示张量沿每个轴的维度大小(元素大小)

- 数据类型(在Python库中通常叫做

dtype)

梯度

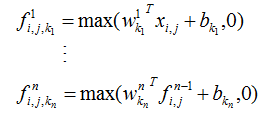

每个神经层都用下述方法对输入数据进行变换。

output = relu(dot(W, input) + b)

W和b都是张量,均为该层的属性。它们被称为该层的权重( weight)或可训练参数( trainable parameter),一开始,这些权重矩阵取较小的随机值,这一步叫作随机初始化( random initialization)。W和b都是随机的,relu(dot(W, input) + b)肯定不会得到任何有用的表示。虽然得到的表示是没有意义的,但这是一个起点。下一步则是根据反馈信号逐渐调节这些权重。这个逐渐调节的过程叫作训练,也就是机器学习中的学习。

上述过程发生在一个训练循环( training loop)内,其具体过程如下(必要时一直重复这些步骤):

- 抽取训练样本

x和对应目标y组成的数据批量 - 在

x上运行网络(这一步叫作前向传播, forward pass),得到预测值y_pred - 计算网络在这批数据上的损失,用于衡量

y_pred和y之间的距离 - 更新网络的所有权重,使网络在这批数据上的损失略微下降

最终得到的网络在训练数据上的损失非常小,即预测值y_pred和预期目标y之间的距离非常小。网络“学会”将输入映射到正确的目标。

计算损失相对于网络系数的梯度( gradient),然后向梯度的反方向改变系数,从而使损失降低。

训练网络

一开始对神经网络的权重随机赋值,因此网络只是实现了一系列随机变换。其输出结果自然也和理想值相去甚远,相应地,损失值也很高。但随着网络处理的示例越来越多,权重值也在向正确的方向逐步微调,损失值也逐渐降低。这就是训练循环( training loop),将这种循环重复足够多的次数(通常对数千个示例进行数十次迭代),得到的权重值可以使损失函数最小。具有最小损失的网络,其输出值与目标值尽可能地接近,这就是训练好的网络。

典型的 Keras 工作流程:

- 定义训练数据:输入张量和目标张量。

- 定义层组成的网络(或模型),将输入映射到目标。

- 配置学习过程:选择损失函数、优化器和需要监控的指标。

- 调用模型的

fit方法在训练数据上进行迭代。

Keras定义模型有两种方法:

- 使用

Sequential类(仅用于层的线性堆叠,这是目前最常见的网络架构) - 函数式

API(functional API,用于层组成的有向无环图,可以构建任意形式的架构)。

为什么需要激活函数?

模型分类:

- 回归模型:预测连续值,是多少的问题。例如,房价是多少?

- 分类模型:预测离散值,是不是的问题。例如,这只动物是不是狗?

卷积层就是我们所做的一大堆特定的滤波器,该滤波器会对某些特定的特征进行强烈的响应,一般情况下是结果值非常大。而对一些无关特性,其响应很小,大部分是结果相对较小,或者几乎为 0。

这样就可以看做为激活,当特定卷积核发现特定特征时,就会做出响应,输出大的数值,而响应函数的存在把输出归为 0~1,那么大的数值就接近 1,小的数值就接近 0。因此在最后计算每种可能所占比重时,自然大的数值比重大。

对于分类问题,画一条直线,这个问题还是比较简单,一条直线解决不了两条就可以了。

这就是一个没有激活函数的网络,可以看出该网络是 x1 和 x2 的线性组合。

线性组合只能是直线

再加一层变为: 。拆开后,结果还是线性的,这样就严重影响了分类的效果,这样根本无法解决非线性问题。

。拆开后,结果还是线性的,这样就严重影响了分类的效果,这样根本无法解决非线性问题。

神经网络的激活函数其实是:将线性转化为非线性的一个函数,并非只是简单地给予 0,或者给予 1。

总而言之,如果不用激活函数,多层神经网络和一层神经网络就没什么区别了。经过多层神经网络的加权计算,都可以展开成一次的加权计算。

交叉熵

刻画了两个概率分布之间的距离,它是分类问题中使用比较广的一种损失函数。给定两个概率分布 p 和 q , 通过 q 来表示 p 的交叉熵为 :

交叉熵刻画的是两个概率分布之间的距离 , 然而神经网络的输出却不一定是一个概率分布。概率分布刻画了不同事件发生的概率。当事件总数有限的情况下 ,概率分布函数  满足 :

满足 :

也就是说,任意事件发生的概率都在 0 和 1 之间,且总有某一个事件发生 (概率的和为 1 )。如果将分类问题中“ 一个样例属于某一个类别”看成一个概率事件,那么训练数据的正确答案就符合一个概率分布。因为事件“一个样例属于不正确的类别”的概率为 1,而“ 一个样例属于正确的类别”的概率为 1 。如何将神经网络前向传播得到的结果也变成概率分布呢? Softmax 回归就是一个非常常用的方法 。

在 TensorFlow 中,Softmax 回归的参数被去掉了,它只是一层额外的处理层,将神经网络的输出变成一个概率分布 。假设原始的神经网络输出为 ,那么经过

,那么经过 Softmax 回归处理之后的输出为 :

从以上公式中可以看出,原始神经网络的输出被用作置信度来生成新的输出,而新的输出满足概率分布的所有要求。这个新的输出可以理解为经过神经网络的推导,一个样例为不同类别的概率分别是多大。这样就把神经网络的输出也变成了一个概率分布,从而可以通过交叉熵来计算预测的概率分布和真实答案的概率分布之间的距离了。

从交叉熵的公式中可以看到,交叉熵函数不是对称( ),它刻画的是通过概率分布

),它刻画的是通过概率分布 q 来表达概率分布 p 的困难程度。因为正确答案是希望得到的结果,所以当交叉熵作为神经网络的损失函数时,p 代表的是正确答案,q 代表的是预测值。交叉熵刻画的是两个概率分布的距离,也就是说交叉熵值越小,两个概率分布越接近。

全连接层的作用

- 全连接层(fully connected layers,FC)在整个卷积神经网络中起到“分类器”的作用。如果说卷积层、池化层和激活函数层等操作是将原始数据映射到隐层特征空间的话,全连接层则起到将学到的“分布式特征表示”映射到样本标记空间的作用。在实际使用中,全连接层可由卷积操作实现:对前层是全连接的全连接层可以转化为卷积核为

1x1的卷积;而前层是卷积层的全连接层可以转化为卷积核为hxw的全局卷积,h和w分别为前层卷积结果的高和宽。 - 目前由于全连接层参数冗余(仅全连接层参数就可占整个网络参数

80%左右),近期一些性能优异的网络模型如 ResNet 和 GoogLeNet 等均用全局平均池化(global average pooling,GAP)取代 FC 来融合学到的深度特征,最后仍用 softmax 等损失函数作为网络目标函数来指导学习过程。需要指出的是,用 GAP 替代 FC 的网络通常有较好的预测性能。 - 在 FC 越来越不被看好的当下,我们近期的研究(In Defense of Fully Connected Layers in Visual Representation Transfer)发现,FC 可在模型表示能力迁移过程中充当“防火墙”的作用。具体来讲,假设在 ImageNet 上预训练得到的模型为

,则 ImageNet 可视为源域(迁移学习中的 source domain)。微调(fine tuning)是深度学习领域最常用的迁移学习技术。针对微调,若目标域(target domain)中的图像与源域中图像差异巨大(如相比 ImageNet,目标域图像不是物体为中心的图像,而是风景照,见下图),不含 FC 的网络微调后的结果要差于含 FC 的网络。因此,FC 可视作模型表示能力的“防火墙”,特别是在源域与目标域差异较大的情况下,FC 可保持较大的模型 capacity 从而保证模型表示能力的迁移(冗余的参数并不一无是处)。

【注】 有关卷积操作“实现”全连接层,需要注意:以 VGG-16 为例,对 224x224x3 的输入,最后一层卷积可得输出为 7x7x512,如后层是一层含 4096 个神经元的 FC,则可用卷积核为 7x7x512x4096 的全局卷积来实现这一全连接运算过程,其中该卷积核参数如下:

filter_size = 7,

padding = 0,

stride = 1,

D_in = 512,

D_out = 4096

经过此卷积操作后可得输出为 1x1x4096。如需再次叠加一个 2048 的 FC,则可设定卷积层操作参数为:

filter_size = 1,

padding = 0,

stride = 1,

D_in = 4096,

D_out = 2048

Dropout

1. Dropout 出现的缘由

在机器学习的模型中,如果模型的参数太多,而训练样本又太少,训练出来的模型很容易产生过拟合的现象。在训练神经网络的时候经常会遇到过拟合的问题,过拟合具体表现在:模型在训练数据上损失函数较小,预测准确率较高;但是在测试数据上损失函数比较大,预测准确率较低。

过拟合是很多机器学习的通病。如果模型过拟合,那么得到的模型几乎不能用。为了解决过拟合问题,一般会采用模型集成的方法,即训练多个模型进行组合。此时,训练模型费时就成为一个很大的问题,不仅训练多个模型费时,测试多个模型也是很费时。

总而言之,训练深度神经网络的时候,总是会遇到两大缺点:

- 容易过拟合

- 费时

Dropout 可以比较有效的缓解过拟合的发生,在一定程度上达到正则化的效果。

2. Dropout 的概念

在 2012 年,Hinton 在其论文《Improving neural networks by preventing co-adaptation of feature detectors》中提出 Dropout。当一个复杂的前馈神经网络被训练在小的数据集时,容易造成过拟合。为了防止过拟合,可以通过阻止特征检测器的共同作用来提高神经网络的性能。

Dropout 可以作为训练深度神经网络的一种 trick 供选择。在每个训练批次中,通过忽略一半的特征检测器(让一半的隐层节点值为 0),可以明显地减少过拟合现象。这种方式可以减少特征检测器(隐层节点)间的相互作用,检测器相互作用是指某些检测器依赖其他检测器才能发挥作用。

简而言之,Dropout 就是在前向传播的时候,让某个神经元的激活值以一定的概率 p 停止工作,这样可以使模型泛化性更强,因为它不会太依赖某些局部的特征,如下图所示。

3. Dropout 具体工作流程

假设要训练这样一个神经网络:

输入是 x,输出是 y,正常的流程是:首先把 x 通过网络前向传播,然后把误差反向传播以决定如何更新参数让网络进行学习。使用 Dropout 之后,过程变成如下:

首先随机(临时)删掉网络中一半的隐藏神经元,输入输出神经元保持不变(下图中虚线为部分临时被删除的神经元)

然后把输入

x通过修改后的网络前向传播,然后把得到的损失结果通过修改的网络反向传播。一小批训练样本执行完这个过程后,在没有被删除的神经元上按照随机梯度下降法更新对应的参数(w, b)。然后继续重复以下过程:

恢复被删掉的神经元(此时被删除的神经元保持原样,而没有被删除的神经元已经有所更新)

从隐藏层神经元中随机选择一个一半大小的子集临时删除掉(备份被删除神经元的参数)。

对一小批训练样本,先前向传播然后反向传播损失并根据随机梯度下降法更新参数

(w, b)(没有被删除的那一部分参数得到更新,删除的神经元参数保持被删除前的结果)。

不断重复这一过程。

4. Dropout 的使用

Dropout 具体怎么让某些神经元以一定的概率停止工作(就是被删除掉)?代码层面如何实现呢?

Dropout 代码层面的一些公式推导及代码实现思路。

1. 在训练模型阶段

无可避免的,在训练网络的每个单元都要添加一个概率流程。

现在描述 dropout 神经网络模型,其中有 L 层隐藏层,隐藏层索引为 。

。 表示第

表示第 层隐藏层的输入向量,

层隐藏层的输入向量,  表示第

表示第 层隐藏层的输出向量(

层隐藏层的输出向量( 表示输入)。

表示输入)。 和

和 分别表示第

分别表示第 层隐藏层的权重与偏置值,

层隐藏层的权重与偏置值, 表示激活函数。

表示激活函数。

对应的公式变化如下:

没有

Dropout的网络计算公式:

采用

Dropout的网络计算公式:

上面公式中,Bernoulli 函数是为了生成概率

r向量,也就是随机生成一个0、1的向量。

代码层面实现让某个神经元以概率 p 停止工作,其实就是让它的激活函数值的从概率 p 变为 0。比如某一层网络神经元的个数为 1000 个,其激活函数输出值为 y1、y2、y3、...、y1000,dropout比率选择 0.4,那么这一层神经元经过 dropout 后,1000 个神经元中会有大约 400 个的值被置为 0。

注意: 经过上面屏蔽掉某些神经元,使其激活值为 0 以后,还需要对向量 y1、y2、y3、...、y1000 进行缩放,也就是乘以 1/(1-p)。如果在训练的时候,经过置 0 后,没有对 y1、y2、y3、...、y1000 进行缩放(rescale),那么在测试的时候,就需要对权重进行缩放,操作如下。

2. 在测试模型阶段

预测模型的时候,每一个神经单元的权重参数要乘以概率 p。

测试阶段 dropout 公式:

5. 为什么Dropout 可以解决过拟合?

- 取平均的作用: 先回到标准的模型(即没有

dropout),用相同的训练数据去训练5个不同的神经网络,一般会得到5个不同的结果,此时可以采用 “5个结果取均值”或者“多数取胜的投票策略“去决定最终结果。例如,3个网络判断结果为数字9,那么很有可能真正的结果就是数字9,其它两个网络给出了错误结果。这种“综合起来取平均”的策略通常可以有效防止过拟合问题。因为不同的网络可能产生不同的过拟合,取平均则有可能让一些“相反的”拟合互相抵消。dropout掉不同的隐藏神经元就类似在训练不同的网络,随机删掉一半隐藏神经元导致网络结构已经不同,整个dropout过程就相当于对很多个不同的神经网络取平均。而不同的网络产生不同的过拟合,一些互为“反向”的拟合相互抵消就可以达到整体上减少过拟合。 - 减少神经元之间复杂的共适应关系: 因为

dropout程序导致两个神经元不一定每次都在一个dropout网络中出现。这样权值的更新不再依赖于有固定关系的隐含节点的共同作用,阻止了某些特征仅仅在其它特定特征下才有效果的情况 。迫使网络去学习更加鲁棒的特征 ,这些特征在其它的神经元的随机子集中也存在。换句话说,假如神经网络是在做出某种预测,它不应该对一些特定的线索片段太过敏感,即使丢失特定的线索,它也应该可以从众多其它线索中学习一些共同的特征。从这个角度看dropout就有点像L1,L2正则,减少权重使得网络对丢失特定神经元连接的鲁棒性提高。

6. Dropout 在 Keras 中的源码分析

def dropout(x, level, noise_shape=None, seed=None):

"""Sets entries in `x` to zero at random,

while scaling the entire tensor.

# Arguments

x: tensor

level: fraction of the entries in the tensor

that will be set to 0.

noise_shape: shape for randomly generated keep/drop flags,

must be broadcastable to the shape of `x`

seed: random seed to ensure determinism.

"""

if level < 0. or level >= 1:

raise ValueError('Dropout level must be in interval [0, 1[.')

if seed is None:

seed = np.random.randint(1, 10e6)

if isinstance(noise_shape, list):

noise_shape = tuple(noise_shape)

rng = RandomStreams(seed=seed)

retain_prob = 1. - level

if noise_shape is None:

random_tensor = rng.binomial(x.shape, p=retain_prob, dtype=x.dtype)

else:

random_tensor = rng.binomial(noise_shape, p=retain_prob, dtype=x.dtype)

random_tensor = T.patternbroadcast(random_tensor,

[dim == 1 for dim in noise_shape])

x *= random_tensor

x /= retain_prob

return x

对 Keras 中 dropout 实现函数做一些修改,让 dropout 函数可以单独运行(函数中,x 是本层网络的激活值,level 就是 dropout 每个神经元要被丢弃的概率)。

import numpy as np

# dropout函数的实现

def dropout(x, level):

#level是概率值,必须在0~1之间

if level < 0. or level >= 1:

raise ValueError('Dropout level must be in interval [0, 1[.')

retain_prob = 1. - level

# 通过binomial函数,生成与x一样的维数向量。binomial函数就像抛硬币一样,可以把每个神经元当做抛硬币一样

# 硬币 正面的概率为p,n表示每个神经元试验的次数

# 因为每个神经元只需要抛一次就可以了,所以n=1,size参数是有多少个硬币。

random_tensor = np.random.binomial(n=1, p=retain_prob, size=x.shape) #即将生成一个0、1分布的向量,0表示这个神经元被屏蔽,不工作了,也就是dropout了

print(random_tensor)

x *= random_tensor

print(x)

x /= retain_prob

return x

#对dropout的测试,大家可以跑一下上面的函数,了解一个输入x向量,经过dropout的结果

x=np.asarray([1,2,3,4,5,6,7,8,9,10],dtype=np.float32)

dropout(x,0.4)

# [1 0 0 0 0 1 1 1 1 0]

# [1. 0. 0. 0. 0. 6. 7. 8. 9. 0.]

# [1 1 1 0 1 1 1 0 0 1]

# [ 1. 2. 3. 0. 5. 6. 7. 0. 0. 10.]

注意: Keras 中 dropout 的实现,是屏蔽掉某些神经元,使其激活值为 0 以后,对激活值向量 x1、...、x1000 进行放大,也就是乘以 1/(1-p)。

在训练的时候会随机的丢弃一些神经元,但是预测的时候就没办法随机丢弃了。如果丢弃一些神经元,这会带来结果不稳定的问题,也就是给定一个测试数据,有时候输出 a ,有时候输出 b,结果不稳定,这是实际系统不能接受的,用户可能认为模型预测不准。那么一种”补偿“的方案就是每个神经元的权重都乘以一个 p,这样在“总体上”使得测试数据和训练数据是大致一样的。比如一个神经元的输出是 x,那么在训练的时候它有 p 的概率参与训练,(1-p) 的概率丢弃,那么它输出的期望是 px+(1-p)0=px。因此,测试的时候把这个神经元的权重乘以 p 可以得到同样的期望。

基础知识

无监督预训练(Unsupervised pre-training)

指预训练阶段的样本不需要人工标注数据

有监督预训练(Supervised pre-training)

也可以将其称为迁移学习。简而言之,就是把一个训练好的参数,拿到另外一个任务上,作为神经网络的初始参数值,这样就比直接采用随机初始化的方法的精度要提升很多。

例如,比如已经有一大堆标注好的人脸年龄分类的图片数据,训练了一个CNN,用于人脸的年龄识别。然后,当新的项目任务是:人脸性别识别时,便可以直接利用已经训练好的年龄识别CNN模型,去掉最后一层,然后其它的网络层参数就直接复制过来,继续进行训练。

Ground Truth

机器学习包括有监督学习(supervised learning),无监督学习(unsupervised learning),和半监督学习(semi-supervised learning)。

在有监督学习中,数据是有标注的,以 (x, t) 的形式出现,其中 x 是输入数据,t 是标注。正确的 t 标注是 ground truth, 错误的标记则不是。(也有人将所有标注数据都叫做 ground truth)

由模型函数的数据则是由 (x, y) 的形式出现的。其中 x 为之前的输入数据,y 为模型预测的值。标注会和模型预测的结果作比较。在损耗函数(loss function / error function)中会将 y 和 t 作比较,从而计算损耗(loss / error)。 比如在最小方差中:

因此,如果标注数据不是 ground truth,那么 loss 的计算将会产生误差,从而影响到模型质量。

例子:(比如输入三维,判断是否性感)

1. 错误的数据

- 标注数据

1:((84,62,86), 1),其中x = (84,62,86),t = 1 - 标注数据

2:((84,162,86), 1),其中x = (84,162,86),t = 1

这里标注数据 1 是 ground truth, 而标注数据 2 不是。

- 预测数据

1:y = -1 - 预测数据

2:y = -1

2. 正确的数据

- 标注数据

1:((84,62,86) ,1),其中x =(84,62,86),t = 1 - 标注数据

2:((84,162,86) ,1),其中x =(84,162,86),t = -1(改为 ground truth)

这里标注数据 1 和 2 都是 ground truth。

- 预测数据

1:y = -1 - 预测数据

2:y = -1

总之一句话:ground truth 就是标定好的真实数据。

模型参数(model parameter)& 模型超参数(model Hyperparameter)

1. 模型参数

模型是模型内部的配置变量,其值可以根据数据进行估计。其属性为:

- 模型在进行预测时需要它们

- 它们的值定义了可使用的模型

- 它们是从数据估计或获悉的

- 它们通常不由编程者手动设置

- 它们通常被保存为学习模型的一部分

参数是机器学习算法的关键,它们通常由过去的训练数据中总结得出。

在经典的机器学习文献中,可以将模型看作假设,将参数视为对特定数据集的量身打造的假设。最优化算法是估计模型参数的有效工具。

- 统计:在统计学中,您可以假设一个变量的分布,如高斯分布。高斯分布的两个参数是平均值(

\μ)和标准偏差(\sigma)。这适用于机器学习,其中这些参数可以从数据中估算出来并用作预测模型的一部分。 - 编程:在编程中,可以将参数传递给函数。在这种情况下,参数是一个函数参数,它可能具有一个值范围之一。在机器学习中,在使用的特定模型是函数时,需要参数才能对新数据进行预测。

模型是否具有固定或可变数量的参数决定了它是否可以被称为“参数”或“非参数”。模型参数的一些示例包括:

- 神经网络中的权重

- 支持向量机中的支持向量

- 线性回归或逻辑回归中的系数

2. 模型超参数

模型超参数是模型外部的配置,其值无法从数据中估计。其性质为:

- 它们通常用于帮助估计模型参数。

- 它们通常由人工指定。

- 它们通常可以使用启发式设置。

- 它们经常被调整为给定的预测建模问题。

虽然无法知道给定问题的模型超参数的最佳值,但可以使用经验法则,在其他问题上使用复制值,或通过反复试验来搜索最佳值。

如果模型超参数被称为模型参数,会造成很多混淆。克服这种困惑的一个经验法则为:如果必须手动指定模型参数,那么它可能是一个模型超参数。

模型超参数的一些例子包括:

- 训练神经网络的学习速率。

- 用于支持向量机的

C和\sigma超参数。 K最近邻的K。

总之,模型参数是根据数据自动估算的。但模型超参数是手动设置的,并且在过程中用于帮助估计模型参数。

top-1 & top-5

ImageNet 图像分类大赛评价标准采用 top-5 错误率,或者top-1错误率,即对一张图像预测5个类别,只要有一个和人工标注类别相同就算对,否则算错。

Top-1 = (正确标记 与 模型输出的最佳标记不同的样本数)/ 总样本数Top-5 = (正确标记 不在 模型输出的前5个最佳标记中的样本数)/ 总样本数

top1 就是你所预测的 label 取最后概率向量里面最大的那一个作为预测结果,如果你的预测结果中概率最大的那个分类正确,则预测正确;否则预测错误。top5 就是最后概率向量最大的前五名中,只要出现了正确概率即为预测正确。否则预测错误。

简而言之,ImageNet 图像通常有 1000 个可能的类别,对每幅图像你可以猜 5 次结果(即同时预测 5 个类别标签),当其中有任何一次预测对了,结果都算对,当 5 次全都错了的时候,才算预测错误,这时候的分类错误率就叫 top5 错误率。同理,top-k 就是对应于有 k 次机会可以进行预测。

epoch

- iteration:表示

1次迭代(也叫 training step),每次迭代更新1次网络结构的参数(batch-size 个训练数据forward+backward后更新参数过程。) - batch-size:

1次迭代所使用的样本量 - epoch:

1个 epoch 表示过了1遍训练集中的所有样本(所有训练数据forward+backward后更新参数的过程)

具体计算公式为:

one epoch = numbers of iterations = N = 训练样本的数量 / batch_size

值得注意的是,在深度学习领域中,常用带 mini-batch 的随机梯度下降算法(Stochastic Gradient Descent, SGD)训练深层结构,它有一个好处就是并不需要遍历全部的样本,当数据量非常大时十分有效。此时,可根据实际问题来定义 epoch,例如定义 10000 次迭代为 1 个 epoch,若每次迭代的 batch-size 设为 256,那么 1 个 epoch 相当于过了 2560000 个训练样本。

感受野(receptive field)

定义

在卷积神经网络 CNN 中,决定某一层输出结果中一个元素所对应的输入层的区域大小,被称作感受野。这段定义非常简单,用数学的语言就是感受野是 CNN 中的某一层输出结果的一个元素对应输入层的一个映射。再通俗点的解释是,feature map 上的一个点对应输入图上的区域【注意:这里是输入图,不是原始图。好多博客写的都是原图上的区域,经过一番的资料查找,发现并不是原图】。

感受野表示输入空间中一个特定 CNN 特征的范围区域(The receptive field is defined as the region in the input space that a particular CNN’s feature is looking at)。一个特征的感受野可以采用区域的中心位置和特征大小进行描述。

目前流行的物体识别方法都是围绕感受野来做的设计,就如 SSD 和 Faster RCNN。理解好感受野的本质有两个好处:

- 理解卷积的本质

- 更好的理解 CNN 的整个架构。

感受野的计算和可视化

CNN特征图可视化的两种方式:

如上图所示,采用卷积核 C 的核大小 ksize=3x3,填充大小 padding=1x1,步长 stride=2x2。(图中上面一行)对 5x5 的输入特征图进行卷积生成 3x3 的绿色特征图。(图中下面一行)对上面绿色的特征图采用相同的卷积操作生成 2x2 的橙色特征图(图中左边一列)按列可视化 CNN 特征图,如果只看特征图,我们无法得知特征的位置(即感受野的中心位置)和区域大小(即感受野的大小),而且无法深入了解 CNN 中的感受野信息。(图中右边一列)CNN 特征图的大小固定,其特征位置即感受野的中心位置。

说的有点晦涩难懂,应该是学术的讲法,简洁的理解就是,左图是常规的卷积过程。而对于右图,卷积后的图像和原图一样大,这个操作起来并不难,就是各个特征(可以理解为图像中的像素点)的位置在卷积后保持不变,空的部分用空白来填充。这样做有什么好处,在我们后面会说到。只要注意到,左图和右图在卷积后,其特征的数目(绿色和黄色点的数目)是一样的。

上图的信息量很大,内容很多,有 CNN 的卷积过程,有感受野的计算公式和过程。弄懂了上图就知道感受野到底是个怎么回事了。

还记得感受野的定义吗?具体看 layer 1 的 feature map 左上角带有红点的特征(可以理解为一个像素),它对应输入 layer 0 的区域大小就是我们要计算的感受野。

很显然,经过 3x3 卷积核卷积后,它对应 layer 0 层上的灰色区域(别忘了还有 padding)。再看 layer 1 到 layer 2 的过程,卷积过程的第一步是先加 padding,p2=1,这里的 1 是特征所占的区域,换句话说就是一个特征所占的感受野。所以 Conv2 过程这张图才会在外面加上了三个格。s2=2 也是同样的道理,步长也是跨过两个特征。k2=3 也是如此,包含 3x3 个特征。经过卷积后就来到了 layer 2 了,左上角特征的感受野大小也很明显了,就是灰色部分。它这一个点可要完成接下来组织交代的历史任务。

这整个过程下来,是不是明白点意思了。感受野的计算有卷积逆过程的意思,这里我不能给出直接的定义,因为还没有权威这么说。之前讲了,明白了感受野的计算能更好理解卷积过程对吧。从上图我们再琢磨一下。特征图的大小逐渐变小,一个特征表示的信息量越来越大,这不就是有点压缩的意思嘛。将原图感兴趣的信息提取出来,不关注的统统抛掉。提的过程就是 CNN 的前向传播,抛的过程就是 CNN 的反馈学习。

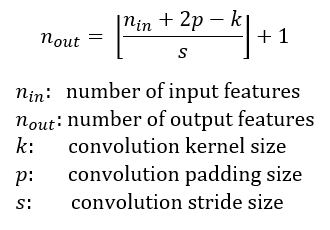

上图展示了一些感受野的例子,采用核大小核大小 ksize=3x3,填充大小 padding=1x1,步长 stride=2x2 的卷积核 C 对 5x5 大小的输入图进行卷积操作,将输出 3x3 大小的特征图(绿色图)。对 3x3 大小的特征图进行相同的卷积操作,将输出 2x2 的特征图(橙色)。输出特征图在每个维度上的大小可以采用下面的公式进行计算:

为了简单,假设 CNN 的架构是对称的,而且输入图像长宽比为 1,因此所有维度上的变量值都相同。若 CNN 架构或者输入图像不是对称的,你也可以分别计算每个维度上的特征图大小。如上图所示,左边一列展示了一种 CNN 特征图的常见可视化方式。这种可视化方式能够获取特征图的个数,但无法计算特征的位置(感受野的中心位置)和区域大小(感受野尺寸)。上图右边一列展示了一种固定大小的 CNN 特征图可视化方式,通过保持所有特征图大小和输入图大小相同来解决上述问题,接下来每个特征位于其感受野的中心。由于特征图中所有特征的感受野尺寸相同,我们就可以非常方便画出特征对应的 bounding box 来表示感受野的大小。因为特征图大小和输入图像相同,所以我们无需将包围盒映射到输入层。

另外一种固定大小的 CNN 特征图表示。采用相同的卷积核 C 对 7x7 大小的输入图进行卷积操作,这里在特征中心周围画出了感受野的 bounding box。为了表达更清楚,这里忽略了周围的填充像素。固定尺寸的 CNN 特征图可以采用 3D(左图)或 2D(右图)进行表示。

上图展示了另外一个例子,采用相同的卷积核 C 对 7x7 大小的输入图进行卷积操作。这里给出了 3D(左图)和 2D(右图)表示下的固定尺寸 CNN 特征图。注意:上图中感受野尺寸逐渐扩大,第二个特征层的中心特征感受野很快就会覆盖整个输入图。这一点对于 CNN 设计架构的性能提升非常重要。

感受野的计算(Receptive Field Arithmetic)

除了每个维度上特征图的个数,还需要计算每一层的感受野大小,因此我们需要了解每一层的额外信息,包括:当前感受野的尺寸 r,相邻特征之间的距离(或者jump)j,左上角(起始)特征的中心坐标 start,其中特征的中心坐标定义为其感受野的中心坐标(如上述固定大小 CNN 特征图所述)。假设卷积核大小 k,填充大小 p,步长大小 s,则其输出层的相关属性计算如下:

- 公式一基于输入特征个数和卷积相关属性计算输出特征的个数

- 公式二计算输出特征图的

jump,等于输入图的jump与输入特征个数(执行卷积操作时jump的个数,stride 的大小)的乘积 - 公式三计算输出特征图的 receptive field size,等于

k个输入特征覆盖区域加上边界上输入特征的感受野覆盖的附加区域

- 公式四计算第一个输出特征的感受野的中心位置,等于第一个输入特征的中心位置,加上第一个输入特征位置到第一个卷积核中心位置的距离

,再减去填充区域大小

。注意:这里都需要乘上输入特征图的

jump,从而获取实际距离或间隔。

例子

用于计算给定 CNN 架构下所有层的感受野信息。程序允许输入任何特征图的名称和图中特征的索引号,输出相关感受野的尺寸和位置。

AlexNet 下感受野计算样例:

# [filter size, stride, padding]

#Assume the two dimensions are the same

#Each kernel requires the following parameters:

# - k_i: kernel size

# - s_i: stride

# - p_i: padding (if padding is uneven, right padding will higher than left padding; "SAME" option in tensorflow)

#

#Each layer i requires the following parameters to be fully represented:

# - n_i: number of feature (data layer has n_1 = imagesize )

# - j_i: distance (projected to image pixel distance) between center of two adjacent features

# - r_i: receptive field of a feature in layer i

# - start_i: position of the first feature's receptive field in layer i (idx start from 0, negative means the center fall into padding)

import math

convnet = [[11,4,0],[3,2,0],[5,1,2],[3,2,0],[3,1,1],[3,1,1],[3,1,1],[3,2,0],[6,1,0], [1, 1, 0]]

layer_names = ['conv1','pool1','conv2','pool2','conv3','conv4','conv5','pool5','fc6-conv', 'fc7-conv']

imsize = 227

def outFromIn(conv, layerIn):

n_in = layerIn[0]

j_in = layerIn[1]

r_in = layerIn[2]

start_in = layerIn[3]

k = conv[0]

s = conv[1]

p = conv[2]

n_out = math.floor((n_in - k + 2*p)/s) + 1

actualP = (n_out-1)*s - n_in + k

pR = math.ceil(actualP/2)

pL = math.floor(actualP/2)

j_out = j_in * s

r_out = r_in + (k - 1)*j_in

start_out = start_in + ((k-1)/2 - pL)*j_in

return n_out, j_out, r_out, start_out

def printLayer(layer, layer_name):

print(layer_name + ":")

print("\t n features: %s \n \t jump: %s \n \t receptive size: %s \t start: %s " % (layer[0], layer[1], layer[2], layer[3]))

layerInfos = []

if __name__ == '__main__':

#first layer is the data layer (image) with n_0 = image size; j_0 = 1; r_0 = 1; and start_0 = 0.5

print ("-------Net summary------")

currentLayer = [imsize, 1, 1, 0.5]

printLayer(currentLayer, "input image")

for i in range(len(convnet)):

currentLayer = outFromIn(convnet[i], currentLayer)

layerInfos.append(currentLayer)

printLayer(currentLayer, layer_names[i])

print ("------------------------")

layer_name = raw_input ("Layer name where the feature in: ")

layer_idx = layer_names.index(layer_name)

idx_x = int(raw_input ("index of the feature in x dimension (from 0)"))

idx_y = int(raw_input ("index of the feature in y dimension (from 0)"))

n = layerInfos[layer_idx][0]

j = layerInfos[layer_idx][1]

r = layerInfos[layer_idx][2]

start = layerInfos[layer_idx][3]

assert(idx_x < n)

assert(idx_y < n)

print ("receptive field: (%s, %s)" % (r, r))

个人聚德计算计算感受野的作用是可以帮助设计网络结构,至少可以大事了解到在每一层的特征所涵盖的信息量。例如,输入图像大小是 250x250的 情况下,如果最后一层的感受野能超过 250 的话,那么可以认为在做最后的分类判断时所用到的特征已经涵盖了原始图像所有范围的信息了。在保证最后一层特征的感受野大小的情况下,如果能够尽可能的降低网络的参数总量,那么就是件很有意义的事情。事实上 inception model 就是这样的思路,通过非对称的结构来降低参数量,同时还能保证感受野。

IoU

物体检测需要定位出物体的 bounding box。如下图所示,不仅要定位出车辆的 bounding box,还需要识别出 bounding box里面的物体就是车辆。对于 bounding box 的定位精度,存在一个定位精度评价公式:IoU(因为算法不可能百分百跟人工标注的数据完全匹配)。

IoU定义了两个 bounding box 的重叠度:

矩形框 A、B的一个重合度 IoU 计算公式为:

即,矩形框 A、B 的重叠面积占 A、B并集的面积比例:

非极大值抑制

非极大值抑制(NMS)就是:抑制不是极大值的元素,搜索局部的极大值。这个局部代表的是一个邻域,邻域有两个参数可变,一是邻域的维数,二是邻域的大小。

【注】:此处不讨论通用的 NMS 算法,而是应用于目标检测中用于提取分数最高的窗口。例如,在行人检测中,滑动窗口经提取特征,经分类器分类识别后,每个窗口都会得到一个分数。但滑动窗口会导致很多窗口与其他窗口存在包含或者大部分交叉的情况。这时就需要用到NMS来选取那些邻域里分数最高(即,行人的概率最大),并且抑制那些分数低的窗口。

RCNN 算法会从一张图片中找出 n 多个可能是物体的矩形框,然后为每个矩形框分别作类别分类概率。

如下图所示,定位一个车辆,最后算法找出了一堆方框,需要判别哪些矩形框是没用的。非极大值抑制法的步骤:先假设有6个矩形框,根据分类器类别分类概率做排序,从小到大分别属于车辆的概率分别为A、B、C、D、E、F:

- 从最大概率矩形框

F开始,分别判断A~E与F的重叠度IoU是否大于某个设定的阈值。 - 假设

B、D与F的重叠度超过阈值,则扔掉B、D,并标记第一个矩形框F是要保留下来的。 - 从剩下的矩形框

A、C、E中,选择概率最大的E,然后判断E与A、C的重叠度IoU,重叠度大于一定的阈值就扔掉;并标记E是保留下来的第二个矩形框。

一直重复,找到所有被保留下来的矩形框。

对梯度幅值进行非极大值抑制

图像梯度幅值矩阵中的元素值越大,说明图像中该点的梯度值越大,但这不不能说明该点就是边缘(这仅仅是属于图像增强的过程)。在 Canny 算法中,非极大值抑制是进行边缘检测的重要步骤,通俗意义上是指:寻找像素点局部最大值,将非极大值点所对应的灰度值置为0,这样可以剔除掉一大部分非边缘的点。

非极大值抑制的工作原理:

由上图可知,要进行非极大值抑制,首先要确定像素点 C 的灰度值在其八邻域内是否为最大。蓝色线条方向为 C 点的梯度方向(这样就可以确定其局部的最大值肯定分布在这条线上),即除了 C 点外,梯度方向的交点 dTmp1 和 dTmp2 这两个点的值也可能会是局部最大值。

因此,判断 C 点灰度与这两个点灰度大小,即可判断 C 点是否为其邻域内的局部最大灰度点。如果经过判断,C 点灰度值小于这两个点中的任一个,那就说明 C 点不是局部极大值,那么则可以排除 C 点为边缘。

在实际中,其实只能得到 C 点邻域的 8 个点的值,而 dTmp1 和 dTmp2 并不在其中。要得到这两个值,就需要对该两个点两端的已知灰度进行线性插值,即根据上图中的 g1 和 g2 对 dTmp1 进行插值,根据 g3 和 g4 对 dTmp2 进行插值,这要用到其梯度方向。

完成非极大值抑制后,会得到一个二值图像,非边缘的点灰度值均为 0,可能为边缘的局部灰度极大值点可设置其灰度为 128。

物体检测 VS 图片分类

物体检测和图片分类的区别:

- 图片分类不需要定位,而物体检测需要定位出物体的位置,也就是相当于把物体的 bbox 检测出来。

- 物体检测是要把所有图片中的物体都识别定位出来。

简言之,物体检测需要定位出物体的位置,这种就相当于回归问题,求解一个包含物体的方框。而图片分类其实是逻辑回归。这种方法对于单物体检测还不错,但是对于多物体检测便显得捉襟见肘。

Selective Search for Object Recognition

目标检测 VS 目标识别

- 目标识别(object recognition)是指明一幅输入图像中存在哪些对象(目标)。它将整张图像作为输入,输出的是该图像中存在的对象(目标)的类标签(class labels)和类概率(class probability)。例如,类标签为“狗”,相关的类概率是

97%。 - 目标检测(object detection)不仅要告诉输入图像中包含了哪类目标,还要框出该目标的具体位置—利用 bounding boxes

(x, y, width, height)来指示图像内对象的位置。

所有的目标检测算法的核心是目标识别算法。在目标检测时,为了定位到目标的具体位置,通常会把图像分成许多子块(sub-regions / patches),然后把子块作为输入,送到目标识别的模型中。生成较小区域最直接方法叫滑动窗口法(Sliding Window Algorithm)。滑动窗口的方法就是按照子块的大小在整幅图像上穷举所有子图像块。这种方法产生的数据量想想都头大。和滑动窗口法相对的是另外一类基于区域(Region Proposal Algorithms)的方法,例如 selective search。

Sliding Window Algorithm

在滑动窗口方法中,在图像上滑动框或窗口以选择 patch,并使用对象识别(object recognition)模型对窗口覆盖的每个图像 patch 进行分类。 它对整个图像上的对象进行详尽搜索:不仅需要搜索图像中的所有可能位置,还必须以不同的比例进行搜索(这是因为物体识别模型通常以特定尺度(或尺度范围)训练)。

滑窗法的物体检测流程图:

通过滑窗法的主要思路:首先对输入图像进行不同窗口大小的滑窗进行从左往右、从上到下的滑动。每次滑动时候,对当前窗口执行分类器(分类器是事先训练好的)。如果当前窗口得到较高的分类概率,则认为检测到了物体。对每个不同窗口大小的滑窗都进行检测后,会得到不同窗口检测到的物体标记,这些窗口大小会存在重复较高的部分,最后采用NMS进行筛选。最终,经过NMS筛选后获得检测到的物体。

滑窗法简单易于理解,但是不同窗口大小进行图像全局搜索导致效率低下,而且设计窗口大小时候还需要考虑物体的长宽比。所以,对于实时性要求较高的分类器,不推荐使用滑窗法。

滑动窗口方法适用于固定宽高比的物体,例如面部或行人。由于图像是3D对象的2D投影,所以宽高比和形状等对象特征会因为拍摄图像的角度而有很大差异。由于滑动窗口方法需要搜索多个宽高比,所以计算将十分耗时。

Region Proposal Algorithms

这种方法将图像作为输入,将输出边 bounding boxes —其对应于图像中最有可能为对象的所有patches。这些区域提议(region proposals)可能是嘈杂的(noisy)、重叠的(overlapping),并且可能没有完全包含对象。但是在这些区域提议中,将有一个非常接近图像中的实际对象的提议(proposal)。然后,可以使用目标识别模型对这些提议进行分类,具有高概率分数的区域提议是对象的位置。

区域提议算法使用分段(segmentation)识别图像中的预期对象。在分割中,基于一些标准(例如颜色,纹理等)将相邻区域进行分组。与在所有像素位置和所有尺度上寻找对象的 sliding window approach 不同,region proposal algorithm 通过以下方式工作:将像素分成为较少数量的段(segments)。因此,生成的最终提案数量比滑动窗口方法少很多倍。这就减少了必须分类的图像 patches 的数量,这些生成的区域提议具有不同的比例和宽高比。

Selective Search

选择搜索算法的主要观点:图像中物体可能存在的区域应该是有某些相似性或者连续性区域的。因此,选择搜索基于上面这一想法采用子区域合并的方法进行提取 bounding boxes 候选边界框。首先,对输入图像进行分割算法产生许多小的子区域。其次,根据这些子区域之间相似性(相似性标准主要有颜色、纹理、大小等等)进行区域合并,不断的进行区域迭代合并。每次迭代过程中对这些合并的子区域做 bounding boxes(外切矩形),这些子区域外切矩形就是通常所说的候选框。

选择搜索的物体检测流程图:

滑窗法类似穷举进行图像子区域搜索,但是一般情况下图像中大部分子区域是没有物体的。选择搜索算法的主要观点:图像中物体可能存在的区域应该是有某些相似性或者连续性区域的。因此,选择搜索基于这一想法,采用子区域合并的方法进行提取 bounding boxes 候选边界框。

- 首先,对输入图像进行分割算法产生许多小的子区域。

- 其次,根据这些子区域之间相似性(相似性标准主要有颜色、纹理、大小等等)进行区域合并,不断的进行区域迭代合并。每次迭代过程中对这些合并的子区域做 bounding boxes(外切矩形),这些子区域外切矩形就是通常所说的候选框。

算法流程:

- step 0:生成区域集

R,具体参见论文《Efficient Graph-Based Image Segmentation》 - step 1:计算区域集

R里每个相邻区域的相似度S = {s1,s2,…} - step 2:找出相似度最高的两个区域,将其合并为新集,添加进

R - step 3:从

S中移除所有与 step 2中有关的子集 - step 4:计算新集与所有子集的相似度

- step 5:跳至 step 2,直至

S为空

相似度计算

Selective Search for Object Recognition论文考虑了颜色、纹理、尺寸和空间交叠这 4 个参数。

颜色相似度(color similarity)

将色彩空间转为 HSV,对于每一个 region 的每个通道以 bins=25 计算直方图,这样每个区域的颜色直方图有 25*3=75 个区间。 对直方图除以区域尺寸做归一化后使用下式计算相似度:

其中, 表示两个不同的 region,

表示两个不同的 region, 表示颜色直方图。

表示颜色直方图。

纹理相似度(texture similarity)

采用方差为1( )的高斯分布在

)的高斯分布在8个方向做梯度统计,然后将统计结果(尺寸与区域大小一致)以bins=10计算直方图。直方图区间数为8*3*10=240(使用RGB色彩空间)

其中, 是直方图中第

是直方图中第 个

个bin的值

尺寸相似度(size similarity)

保证合并操作的尺度较为均匀,避免一个大区域陆续“吃掉”其他小区域。

例子:

设有区域 a-b-c-d-e-f-g-h :

- 较好的合并方式是:

ab-cd-ef-gh -> abcd-efgh -> abcdefgh。 - 不好的合并方法是:

ab-c-d-e-f-g-h ->abcd-e-f-g-h ->abcdef-gh -> abcdefgh。

交叠相似度(shape compatibility measure)

例子:左图适于合并,右图不适于合并

最终的相似度

池化层

池化层可以非常有效地缩小矩阵的尺寸,从而减少最后全连接层中的参数。使用池化层,既可以加快计算速度,也有防止过拟合问题的作用。

池化层前向传播的过程也是通过移动 一个类似过滤器的结构完成的 。不过池化层过滤器中 的计算不是节点的加权和,而是采用更加简单的最大值或者平均值运算。使用最大值操作的池化层被称之为最大池化层( max pooling ),这是被使用得最多的池化层结构。使用平均值操作的池化层被称之为平均池化层( average pooling )。

卷积层和池化层中过滤器移动的方式是相似的,唯一的区别在于卷积层使用的过滤器是横跨整个深度的,而池化层使用 的过滤器只影响一个深度上的节点。所以池化层 的过滤器除了在长和宽两个维度移动 ,它还需要在深度这个维度移动。

LeNet

第一层:卷积层

这一层的输入就是原始的图像像素 , LeNet 模型接受的输入层大小为 32×32×l。第一个卷积层 filter 的尺寸为 5×5,深度为 6,不使用全 0 填充,步长为 1 。因为没有使用全 0 填充,所以这 一 层的输出 的尺寸为 32-5+1=28, 深度为 6 。这一个卷积层总共有 5×5×6+6=156 个参数,其中 6 个为偏置项参数。因为下一层的节点矩阵有 28×28=4704 个节点,每个节点和 5×5=25 个当前层节点相连,所以本 层卷积层总共有 4704×(25+1)=122304 个连接。

第二层:池化层

这一层的输入为第一层的输出, 是一个 28×28×6 的节点矩阵。本层采用的 filter 大小为 2×2,长和宽的步长均为 2,所以本层的输出矩阵大小为 14×14×6。

第三层:卷积层

本层的输入矩阵大小为 14×14×6,使用的 filter 大小为 5×5 ,深度为 16。本层不使用全 0 填充, 步长为 l。本层的输出矩阵大小为 10×10×16。按照标准的卷积层 ,本层应该有 5×5×6×16+16=2416 个参数,10×10×16×(25+1)=41600 个连接。

第四层:池化层

本层的输入矩阵大小为 10×l0×16,采用的 filter 大小为 2×2,步长为 2。本层的输出矩阵大小为 5×5×l6。

第五层:全连接层

本层的输入矩阵大小为 5×5×16,在 LeNet 模型的论文中将这一层称为卷积层,但是因为 filter 的大小就是 5×5,所以和全连接层没有区别。如果将 5×5×16 矩阵中的节点拉成一个向量,那么这一层和全连接层输入就一样了。本层的输出节点个数为 120个,总共有 5×5×16×120+120=48120 个参数。

第六层:全连接层

本层的输入节点个数为 120 个,输出节点个数为 84 个,总共参数为 120×84+84=10164个。

第七层:全连接层

本层的输入节点个数为 84 个,输出节点个数为 10 个,总共参数为 84×10+10=850 个 。

TensorFlow 的实现(LeNet.py,在 MNIST 中为 mnist_train.py):

# 配置神经网络参数

INPUT_NODE = 784

OUTPUT_NODE = 10

IMAGE_SIZE = 28

NUM_CHANNELS = 1

NUM_LABELS = 10

# 第一层卷积层的尺寸和深度

CONV1_DEEPTH = 32

CONV1_SIZE = 5

# 第二层卷积层的尺寸和深度

CONV2_DEEPTH = 64

CONV2_SIZE = 5

# 全连接层的结点个数

FC_SIZE = 512

# 次函数表示CNN的的前向传播过程。其中,train用于表示:区分训练过程还是测试过程。

def inference(input_tensor, train, regularizer):

# 第一层卷积层,和标准的LeNet模型不太一样。

# 卷积层的输入为:28*28*1 即原始的MNIST图片的像素

# 使用全0填充

# 输出为:28*28*32的矩阵

with tf.variable_scope('layer1_conv1'):

# 5*5*32

conv1_weights = tf.get_variable(

'weight',

[CONV1_SIZE, CONV1_SIZE, NUM_CHANNELS, CONV1_DEEPTH],

initializer = tf.truncated_normal_initializer(stddev=0.1)

)

conv1_biases = tf.get_variable(

'bias',

[CONV1_DEEPTH],

initializer = tf.constant_initializer(0.0)

)

# 使用边长为5,深度为32的filter,filter移动的步长为1,且使用全0填充。

conv1 = tf.nn.conv2d(

input_tensor,

conv1_weights,

strides = [1, 1, 1, 1],

padding = 'SAME'

)

relu1 = tf.nn.relu(tf.nn.bias_add(conv1, conv1_biases))

with tf.name_scope('layer2_pool1'):

# 这一层的输入是上一层的输出:28*28*32

# 池化层filter为:2*2 全0填充 移动步长为2

# 输出为:14*14*32

pool1 = tf.nn.max_pool(

relu1, ksize=[1, 2, 2, 1], strides=[1, 2, 2, 1], padding='SAME')

# 这一层的输入为:14*14*32

# 输出为:14*14*64

with tf.name_scope('layer3_conv2'):

conv2_weights = tf.get_variable(

'weight',

# 5*5*32*64

[CONV2_SIZE, CONV2_SIZE, CONV1_DEEPTH, CONV2_DEEPTH],

initializer=tf.truncated_normal_initializer(stddev=0.1))

conv2_biases = tf.get_variable(

'bias',

[CONV2_DEEPTH], # 64

initializer=tf.constant_initializer(0.0))

# 使用边长为5,深度为64的过滤器,过滤器移动的步长为1

conv2 = tf.nn.conv2d(

pool1,

conv2_weights,

strides=[1, 1, 1, 1],

padding='SAME')

relu2 = tf.nn.relu(tf.nn.bias_add(conv2, conv2_biases))

# 输入为:14*14*64

# 输出为:7*7*64

with tf.name_scope('layer4_pool2'):

pool2 = tf.nn.max_pool(

relu2, ksize=[1,2,2,1], strides=[1,2,2,1], padding='SAME')

pool_shape = pool2.get_shape().as_list()

# pool_shape[0]:为一个 batch 中数据的大小

nodes = pool_shape[1] * pool_shape[2] * pool_shape[3]

# 将第四层的输出转化为一个 batch 的向量

reshaped = tf.reshape(pool2, [pool_shape[0], nodes])

# 这一层的输入是拉直之后的一组向量,长度为:7*7*64=3136。输出为:512的向量

with tf.variable_scope('layer5_fc1'):

fc1_weights = tf.get_variable(

'weight',

[nodes, FC_SIZE],

initializer=tf.truncated_normal_initializer(stddev=0.1))

# 只有全连接层的权重才需要加入正则化

if regularizer != None:

tf.add_to_collection('losses', regularizer(fc1_weights))

fc1_biases = tf.get_variable(

'bias',

[FC_SIZE],

initializer=tf.constant_initializer(0.1))

fc1 = tf.nn.relu(tf.matmul(reshaped, fc1_weights) + fc1_biases)

if train:

fc1 = tf.nn.dropout(fc1, 0.5)

with tf.variable_scope('layer6_fc2'):

fc2_weights = tf.get_variable(

'weight',

[FC_SIZE, NUM_LABELS],

initializer=tf.truncated_normal_initializer(stddev=0.1))

if regularizer != None:

tf.add_to_collection('losses', regularizer(fc2_weights))

fc2_biases = tf.get_variable(

'bias',

[NUM_LABELS],

initializer=tf.constant_initializer(0.1))

logit = tf.matmul(fc1, fc2_weights) + fc2_biases

return logit

MNIST 训练过程(mnist_train.py):

import os

import numpy as np

import tensorflow as tf

from tensorflow.examples.tutorials.mnist import input_data

# 加载mnist_inference.py中定义的常量和前向传播的函数

import mnist_inference

# 配置神经网络的参数

BATCH_SIZE = 100

# 一个训练 batch 中的训练数据的数量。

# - 数字越小时,训练过程越接近随机梯度下降

# - 数字越大时,训练就越接近梯度下降

LEARNING_RATE_BASE = 0.01 # 基础学习率

LEARNING_RATE_DECAY = 0.99 # 学习率的衰减率

REGULARAZTION_RATE = 0.0001 # 正则化项中的 \lambda 系数

TRAINING_STEPS = 30000 # 训练轮数

MOVING_AVERAGE_DECAY = 0.99 # 滑动平均衰减率

# 模型保存的路径和文件名

MODEL_SAVE_PATH = "model/"

MODEL_NAME = "model.ckpt"

def train(mnist):

# 定义输入输出placeholder

# 调整输入数据placeholder的格式,输入为一个四维矩阵

x = tf.placeholder(

tf.float32,

[BATCH_SIZE, # 第一维表示一个batch中样例的个数

mnist_inference.IMAGE_SIZE, # 第二维和第三维表示图片的尺寸

mnist_inference.IMAGE_SIZE,

mnist_inference.NUM_CHANNELS], # 第四维表示图片的深度

name='x-input')

y_ = tf.placeholder(

tf.float32,

[None, mnist_inference.OUTPUT_NODE],

name='y-input')

# L2 正则化项

regularizer = tf.contrib.layers.l2_regularizer(REGULARAZTION_RATE)

# 直接使用 mnist_inference.py 中定义的前向传播过程

y = mnist_inference.inference(x, True, regularizer)

# 在使用 TensorFlow 训练神经网络时,

# 一般会将代表训练轮数的变量指定为不可训练的参数。

global_step = tf.Variable(0, trainable=False)

# 定义损失函数、学习率、滑动平均操作以及训练过程

# 创建一个滑动平均类,设置的初始滑动平均衰减率为 0.99,并设置了训练轮数

# 给定训练轮数的变量可以加快训练早期变量的更新速度。

variable_averages = tf.train.ExponentialMovingAverage(MOVING_AVERAGE_DECAY, global_step)

# 在所有代表神经网络参数的变量上使用滑动平均。其他辅助变量(比如 global_step)就

# 不需要。tf.trainable_variables 返回的就是图上集合 GraphKeys.TRAINABLE_VARIABLES

# 中的元索。这个集合的元索就是所有没有指定 trainable=False 的参数。

variable_averages_op = variable_averages.apply(tf.trainable_variables())

# 计算交叉熵作为刻画预训值和真实值之间差距的损失函数。这里使用了 TensorFlow 中提

# 供的 sparse_softmax_cross_entropy_with_logits 函数来计算交叉熵。当分类

# 问题只有一个正确答案时,可以使用这个函数来加速交叉熵的计算。MNIST问题的图片中

# 只包含了 0~9 中的一个数字,所以可以使用这个函数来计算交叉熵损失。

# 第一个参数是神经网络不包括 softmax 层的前向传播结果

# 第二个是训练数据的正确答案

# 因为标准答案是 1 个长度为 10 的一维数组,而该函数需要提供的是一个正确答案的数字

# 所以需要使用 tf.argmax 函数来得到正确答案对应的类别编号。

cross_entropy = tf.nn.sparse_softmax_cross_entropy_with_logits(logits=y, labels=tf.argmax(y_, 1))

# 计算在当前 batch 中所有样例的交叉熵平均值。

cross_entropy_mean = tf.reduce_mean(cross_entropy)

# 总损失 = 交叉熵损 + 正正则化损失

loss = cross_entropy_mean + tf.add_n(tf.get_collection('losses'))

# 设置指数衰减学习率

learning_rate = tf.train.exponential_decay(

LEARNING_RATE_BASE, # 初始学习率,随着迭代的进行,更新变量时使用的学习率在这个基础上递减

global_step, # 当前迭代轮数

mnist.train.num_examples/BATCH_SIZE, # 过完所有的训练数据所需要的迭代次数

LEARNING_RATE_DECAY) # 学习率衰减速度

# 优化损失函数

train_step = tf.train.GradientDescentOptimizer(learning_rate).minimize(loss, global_step=global_step)

# 在训练神经网络模型时,每过一遍数据:

# - 需要通过反向传播来更新神经网络中的参数,

# - 需要更新每一个参数的滑平均动值。

# 为了一次完成多个操作,TensorFlow 提供了tf.control_dependencies 和 tf.group 两种机制。

# 下式等价于:train_op = tf.group(train_step, variables_averages_op)

with tf.control_dependencies([train_step, variable_averages_op]):

train_op = tf.no_op(name='train')

# 初始化 Tensorflow 持久化类

saver = tf.train.Saver()

with tf.Session() as sess:

tf.global_variables_initializer().run()

# 验证和测试的过程将会有一个独立的程序来完成

# 一共训练 30000 轮

for i in range(TRAINING_STEPS):

# 每次训练所取的 batch 中的训练样本数为 100

xs, ys = mnist.train.next_batch(BATCH_SIZE)

# 将输入的训练数据格式调整为一个四维矩阵,并将这个调整后的数据传入sess.run过程

# xs 的 shape 为 (100, 784),其中 100 就是 batch_size 的大小,即 100 张图片

# 经过reshape之后,变为 (100, 28, 28, 1),100张图片,每张图片像素为 28*28,深度为 1

reshaped_xs = np.reshape(xs, ( BATCH_SIZE, # 100

mnist_inference.IMAGE_SIZE, # 28

mnist_inference.IMAGE_SIZE, # 28

mnist_inference.NUM_CHANNELS) # 1

)

# 将经过reshape之后的输入传入CNN之中,将结果保存在y_之中

_, loss_value, step = sess.run(

[train_op, loss, global_step],

feed_dict={x: reshaped_xs, y_: ys})

# 每1000轮保存一次模型。

if i % 1000 == 0:

# 输出当前的训练情况。这里只输出了模型在当前训练batch上的损失函数大小。通过损失函数的大小可以大概了解训练的情况。

# 在验证数据集上的正确率信息会有一个单独的程序来生成。

print("After %d training step(s), loss on training batch is %f." % (step, loss_value))

# 保存当前的模型。这里给出了global_step参数,这样可以让每个被保存模型的文件名末尾加上训练的轮数,比如“model.ckpt-1000”表示训练1000轮后得到的模型

saver.save(sess, os.path.join(MODEL_SAVE_PATH, MODEL_NAME), global_step=global_step)

def main(argv=None):

mnist = input_data.read_data_sets("dataset/", False, one_hot=True)

train(mnist)

if __name__ == '__main__':

tf.app.run()

接下来,就是验证(mnist_eval.py):

import time

import numpy as np

import tensorflow as tf

from tensorflow.examples.tutorials.mnist import input_data

# 加载mnist_inference.py 和 mnist_train.py中定义的常量和函数

import mnist_inference

import mnist_train

# 每10秒加载一次最新的模型, 并在测试数据上测试最新模型的正确率

EVAL_INTERVAL_SECS = 10

def evaluate(mnist):

with tf.Graph().as_default() as g:

# 定义输入输出的格式

x = tf.placeholder(

tf.float32,

[mnist.validation.num_examples, # 第一维表示样例的个数

mnist_inference.IMAGE_SIZE, # 第二维和第三维表示图片的尺寸

mnist_inference.IMAGE_SIZE,

mnist_inference.NUM_CHANNELS],

name='x-input')

y_ = tf.placeholder(

tf.float32,

[None, mnist_inference.OUTPUT_NODE],

name='y-input')

validate_feed = {

x: np.reshape(mnist.validation.images,

(mnist.validation.num_examples,

mnist_inference.IMAGE_SIZE,

mnist_inference.IMAGE_SIZE,

mnist_inference.NUM_CHANNELS)),

y_: mnist.validation.labels

}

# 直接通过调用封装好的函数来计算前向传播的结果。

# 因为测试时不关注正则损失的值,所以这里用于计算正则化损失的函数被设置为None。

y = mnist_inference.inference(x, False, None)

# 使用前向传播的结果计算正确率。

# 如果需要对未知的样例进行分类,那么使用tf.argmax(y,1)就可以得到输入样例的预测类别了。

correct_prediction = tf.equal(tf.argmax(y, 1), tf.argmax(y_, 1))

accuracy = tf.reduce_mean(tf.cast(correct_prediction, tf.float32))

# 通过变量重命名的方式来加载模型,这样在前向传播的过程中就不需要调用求滑动平均的函数来获取平局值了。

# 这样就可以完全共用mnist_inference.py中定义的前向传播过程

variable_averages = tf.train.ExponentialMovingAverage(mnist_train.MOVING_AVERAGE_DECAY)

variable_to_restore = variable_averages.variables_to_restore()

saver = tf.train.Saver(variable_to_restore)

#每隔EVAL_INTERVAL_SECS秒调用一次计算正确率的过程以检测训练过程中正确率的变化

while True:

with tf.Session() as sess:

# tf.train.get_checkpoint_state函数会通过checkpoint文件自动找到目录中最新模型的文件名

ckpt = tf.train.get_checkpoint_state(mnist_train.MODEL_SAVE_PATH)

if ckpt and ckpt.model_checkpoint_path:

# 加载模型

saver.restore(sess, ckpt.model_checkpoint_path)

# 通过文件名得到模型保存时迭代的轮数

global_step = ckpt.model_checkpoint_path.split('/')[-1].split('-')[-1]

accuracy_score = sess.run(accuracy, feed_dict = validate_feed)

print("After %s training step(s), validation accuracy = %f" % (global_step, accuracy_score))

else:

print("No checkpoint file found")

return

time.sleep(EVAL_INTERVAL_SECS)

def main(argv=None):

mnist = input_data.read_data_sets("dataset/", one_hot=True)

evaluate(mnist)

if __name__ == '__main__':

tf.app.run()

以下是自己手写图片的识别:

import time

import numpy as np

import tensorflow as tf

from PIL import Image

import matplotlib.pyplot as plt

from tensorflow.examples.tutorials.mnist import input_data

# 加载mnist_inference.py 和 mnist_train.py中定义的常量和函数

import mnist_inference

import mnist_train

def evaluate(image_array):

with tf.Graph().as_default() as g:

# 定义输入输出的格式

x = tf.placeholder(

tf.float32,

[1, # 第一维表示样例的个数

mnist_inference.IMAGE_SIZE, # 第二维和第三维表示图片的尺寸

mnist_inference.IMAGE_SIZE,

mnist_inference.NUM_CHANNELS], # 第四维表示图片的深度

name='x-input')

y = mnist_inference.inference(x, False, None)

prediction_value = tf.argmax(y, 1)

# 通过变量重命名的方式来加载模型,这样在前向传播的过程中就不需要调用求滑动平均的函数来获取平局值了。

# 这样就可以完全共用mnist_inference.py中定义的前向传播过程

variable_averages = tf.train.ExponentialMovingAverage(mnist_train.MOVING_AVERAGE_DECAY)

variable_to_restore = variable_averages.variables_to_restore()

saver = tf.train.Saver(variable_to_restore)

with tf.Session() as sess:

# tf.train.get_checkpoint_state函数会通过checkpoint文件自动找到目录中最新模型的文件名

ckpt = tf.train.get_checkpoint_state(mnist_train.MODEL_SAVE_PATH)

if ckpt and ckpt.model_checkpoint_path:

# 加载模型

saver.restore(sess, ckpt.model_checkpoint_path)

# 通过文件名得到模型保存时迭代的轮数

prediction_value = sess.run(prediction_value,

feed_dict={x: np.reshape(image_array, (1, mnist_inference.IMAGE_SIZE, mnist_inference.IMAGE_SIZE, mnist_inference.NUM_CHANNELS))})

return prediction_value

else:

print("No checkpoint file found")

return

# def pre_pic(picName):

# # 先打开传入的原始图片

# img = Image.open(picName)

# # 使用消除锯齿的方法resize图片

# reIm = img.resize((28,28),Image.ANTIALIAS)

# # 变成灰度图,转换成矩阵

# im_arr = np.array(reIm.convert("L"))

# threshold = 50#对图像进行二值化处理,设置合理的阈值,可以过滤掉噪声,让他只有纯白色的点和纯黑色点

# for i in range(28):

# for j in range(28):

# im_arr[i][j] = 255-im_arr[i][j]

# if (im_arr[i][j]<threshold):

# im_arr[i][j] = 0

# else:

# im_arr[i][j] = 255

# # 将图像矩阵拉成1行784列,并将值变成浮点型(像素要求的仕0-1的浮点型输入)

# nm_arr = im_arr.reshape([1,784])

# nm_arr = nm_arr.astype(np.float32)

# img_ready = np.multiply(nm_arr,1.0/255.0)

# return img_ready

# 图片预处理函数

def process_image():

file_name='pic/2.png' # 导入自己的图片地址

image = Image.open(file_name).convert('L')

image_array = [(255-x)*1.0/255.0 for x in list(image.getdata())]

return image_array

def main(argv=None):

image_array = process_image()

# 将处理后的结果输入到预测函数最后返回预测结果

prediction_value = evaluate(image_array)

print("The prediction number is : ", prediction_value)

if __name__ == '__main__':

tf.app.run()

# 从mnist中读取数字

# mnist = input_data.read_data_sets("dataset/", False, one_hot=True)

# tf.reset_default_graph()

# im = mnist.test.images[1].reshape((28,28))

# img = Image.fromarray(im*255)

# img = img.convert('RGB')

# img.save(r'pic\2.jpg')

# plt.imshow(im, cmap="gray")

# plt.show()

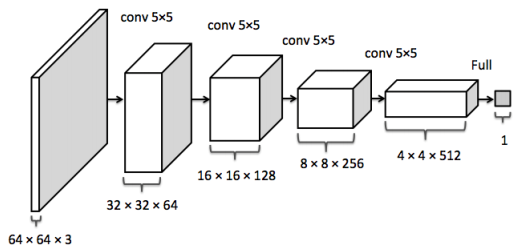

如何设计卷积神经网络的架构呢?以下正则表达式公式总结了一些经典的用于图片分类问题的卷积神经网络架构 :

输入层 --> (卷积层+ --> 池化层?)+ --> 全连接层+

在以上公式中:

卷积层+表示一层或者多层卷积层,大部分卷积神经网络中一般最多连续使用三层卷积层。池化层?表示没有或者一层池化层。池化层虽然可以起到减少参数防止过拟合问题,但是在部分论文中也发现可以直接通过调整卷积层步长来完成。 所以有些卷积神经网络中没有地化层。在多轮卷积层和池化层之后,卷积神经网络在输出之前一般会经过1~2个全连接层。

比如 LeNet-5 模型就可以表示为以下结构。

输入层 --> 卷积层 --> 池化层 --> 卷积层 --> 池化层 --> 全连接层 --> 全连接层 --> 输出层

在输入和输出层之间的神经网络叫做隐藏层, 一般一个神经网络的隐藏层越多,这个神经网络越“深”。而所谓深度学习中的这个“深度”和神经网络的层数也是密切相关的。

RCNN

整体过程:

- 输入一张多目标图像,采用 selective search 算法提取约

2000个建议框 - 先在每个建议框周围加上

16个像素值为建议框像素平均值的边框,再直接变形为227×227的大小 - 先将所有建议框像素减去该建议框像素平均值后【预处理操作】,再依次将每个

227×227的建议框输入 AlexNet CNN 网络获取4096维的特征【比以前的人工经验特征低两个数量级】,2000个建议框的CNN特征组合成2000×4096维矩阵 - 将

2000×4096维特征与20个 SVM 组成的权值矩阵4096×20相乘【20种分类,SVM 是二分类器,则有20个 SVM】,获得2000×20维矩阵表示每个建议框是某个物体类别的得分 - 分别对上述

2000×20维矩阵中每一列即每一类进行非极大值抑制剔除重叠建议框,得到该列即该类中得分最高的一些建议框 - 分别用

20个回归器对上述20个类别中剩余的建议框进行回归操作,最终得到每个类别的修正后的得分最高的 bounding box

1. 算法的整体思路

通过利用 recongnition using regions 操作来解决 CNN 的定位问题,此方法在目标检测和语义分割中都取得了成功。测试阶段,此方法对每一个输入的图片产生近 2000 个不分种类的 region proposals,使用 CNN 从每个 region proposals 中提取一个固定长度的特征向量,然后对每个 region proposal 提取的特征向量使用特定种类的线性SVM进行分类(CNN + SVM for classification)。

RCNN 采用的方法是:首先输入一张图片,先定位出 2000 个物体候选框,然后采用 CNN 提取每个候选框中图片的特征向量,特征向量的维度为 4096 维,接着采用 SVM 算法对各个候选框中的物体进行分类识别。

RCNN 算法主要分为四个步骤:

- 找出候选框(一张图像生成

1K~2K个候选区域 ) - 利用 CNN 提取特征向量(对每个候选区域,使用深度网络提取特征 )

- 利用 SVM 进行特征向量分类( 特征送入每一类的 SVM 分类器,判别是否属于该类)

- 使用回归器精细修正候选框位置

2. 候选框的搜索

当输入一张图片时,搜索出所有可能是物体的区域,这个采用的方法是传统文献的算法:《Selective Search for Object Recognition》,通过这个算法可以搜索出 2000 个候选框(搜出的候选框是矩形的,而且是大小各不相同)。然而,CNN 对输入图片的大小的要求是固定的,如果把搜索到的矩形选框不做处理,就扔进 CNN 中,肯定不行。

因此,对于每个输入的候选框都需要缩放到固定的大小。为了简单起见,假设下一阶段 CNN 所需要的输入图片大小是个正方形图片:227×227。由于经过 selective search 得到的是矩形框,可以采用两种不同的处理方法:

1. 各向异性缩放

即不管图片的长宽比例,也不管其是否扭曲,直接缩放成 CNN 输入的大小 227×227(如图 (D) 所示)。

2. 各向同性缩放

因为图片扭曲后,可能会对后续 CNN 的训练精度有影响。各向同性缩放有两种方案:

- 直接在原始图片中,把 bounding box 的边界扩展延伸成正方形,然后再进行裁剪;如果已经延伸到了原始图片的外边界,那么就用 bounding box 中的颜色均值填充(如图

(B)所示)。 - 先把 bounding box 图片裁剪出来,然后用固定的背景颜色填充成正方形图片(背景颜色也采用 bounding box 的像素颜色均值,如图

(C)所示)。

得到指定大小的图片后,后面还要继续用这 2000 个候选框图片继续训练 CNN、SVM。在一张图中,人工标注时就只标注了正确的 bounding box,搜索出来的 2000 个矩形框不可能会出现一个与人工标注完全匹配的候选框。

因此,需要用 IoU 为 2000 个 bounding box 打标签,以便下一步 CNN 训练使用。在 CNN 阶段,如果用 selective search 挑选出来的候选框与物体的人工标注矩形框的重叠 IoU 大于 0.5,就把这个候选框标注成物体类别,否则就把它当做背景类别。

非极大值抑制的具体操作

在测试过程完成到第 4 步之后,获得 2000×20 维矩阵表示每个建议框是某个物体类别的得分情况,此时会遇到下图所示情况,同一个车辆目标会被多个建议框包围,这时需要非极大值抑制操作去除得分较低的候选框以减少重叠框。

步骤:

- 对

2000×20维矩阵中每列按从大到小进行排序 - 从每列最大的得分建议框开始,分别与该列后面的得分建议框进行

IoU计算,若IoU > 阈值,则剔除得分较小的建议框,否则认为图像中存在多个同一类物体 - 从每列次大的得分建议框开始,重复步骤

2 - 重复步骤

3,直到遍历完该列所有建议框 - 遍历完

2000×20维矩阵所有列,即所有物体种类都做一遍非极大值抑制 - 最后剔除各个类别中剩余建议框得分少于该类别阈值的建议框

3. CNN特征提取

1. 网络结构设计

网络结构有两个可选方案:

- 经典的 Alexnet

- VGG16

经过测试,Alexnet 精度为 58.5%,VGG16 精度为 66%。 VGG 模型的特点是:选择比较小的卷积核、选择较小的跨步,这个网络的精度高,不过计算量是 Alexnet 的 7 倍。为简单起见,直接选用 Alexnet。Alexnet 特征提取部分包含了 5 个卷积层、3 个全连接层,在 Alexnet 中 p5 层神经元个数为 9216,f6、f7 的神经元个数都是 4096,通过这个网络训练完毕后,最后提取特征每个输入候选框图片都能得到一个 4096 维的特征向量。

2. 有监督预训练

参数初始化部分:物体检测的一个难点在于,物体标签训练数据少,如果直接采用随机初始化 CNN 参数的方法,那么目前的训练数据量是远远不够的。

这种情况下,最好的是采用某些方法,把参数初始化了,然后再进行有监督的参数微调。RCNN 采用有监督的预训练,所以在设计网络结构时,直接用 Alexnet 的网络(连参数也是直接采用它的参数,作为初始的参数值,然后再 fine-tuning 训练)。网络优化求解:采用随机梯度下降法,学习速率大小为 0.001。

3. fine-tuning 训练

采用 selective search 搜索出来的候选框,处理到指定的大小,继续对上面预训练的 CNN 模型进行 fine-tuning 训练。

假设要检测的物体类别有 N 类,那么就需要把上面预训练阶段的 CNN 模型的最后一层给替换掉,替换成 N+1 个输出的神经元(加 1,表示还有一个背景),然后这一层直接采用参数随机初始化的方法,其它网络层的参数不变。接着进行 SGD 训练。开始的时候,SGD 学习率选择 0.001,在每次训练的时候,batch size 大小选择 128(其中,32 个为正样本、96 个为负样本)。

疑问

1. 既然 CNN 都是用于提取特征,那么直接用 Alexnet 做特征提取,省去 fine-tuning 阶段可以吗?

可以。可以不需重新训练 CNN,直接采用 Alexnet 模型,提取出 p5 或者 f6、f7 的特征作为特征向量,然后进行训练 SVM(只不过这样精度会比较低)。

2. 没有 fine-tuning 的时候,要选择哪一层的特征作为 CNN 提取到的特征呢?由于可以选择 p5、f6、f7,这三层的神经元个数分别是 9216、4096、4096。从 p5 到 p6 这层的参数个数是:4096*9216,从 f6 到 f7 的参数是4096*4096。那么具体是选择 p5、f6 还是 f7 呢?

RCNN 论文证明了一个理论:如果不进行 fine-tuning,即直接把 Alexnet 模型当做万金油使用,类似于 HOG、SIFT 一样做特征提取,不针对特定的任务,然后把提取的特征用于分类,结果发现 p5 的精度竟然跟 f6、f7 差不多,而且 f6 提取到的特征还比 f7 的精度略高;如果进行了 fine-tuning,那么 f7、f6 提取到的特征就会让训练的 SVM 分类器的精度飙涨。

据此,如果不针对特定任务进行 fine-tuning,而是把 CNN 当做特征提取器的话,卷积层所学到的特征其实就是基础的共享特征提取层,就类似于 SIFT 算法一样,可以用于提取各种图片的特征,而 f6、f7 所学习到的特征是用于针对特定任务的特征。打个比方:对于人脸性别识别来说,一个 CNN 模型前面的卷积层所学习到的特征就类似于学习人脸共性特征,然后全连接层所学习的特征就是针对性别分类的特征。

3. CNN 在进行训练的时候,本来就是对 bounding box 的物体进行识别分类训练,是一个端到端的任务。在训练的最后一层 softmax 就是分类层,那么为什么要先用 CNN 做特征提取(提取 fc7层数据),然后再把提取的特征用于训练 SVM 分类器?

这是因为 SVM 训练和 CNN 训练过程的正负样本定义方式各有不同,导致最后采用 CNN softmax 输出比采用 SVM 精度还低。

CNN 在训练的时候,对训练数据做了比较宽松的标注(比如一个 bounding box 可能只包含物体的一部分),那么把它也标注为正样本,用于训练 CNN;采用这个方法的主要原因在于 CNN 容易过拟合,所以需要大量的训练数据。在 CNN 训练阶段,是对 bounding box 的位置限制条件限制的比较松(IoU 只要大于 0.5 都被标注为正样本);

然而 SVM 训练的时候,因为 SVM 适用于少样本训练,所以对于训练样本数据的 IoU 要求比较严格,只有当bounding box 把整个物体都包含进去了,才把它标注为物体类别,然后训练 SVM。

4. 为什么需要回归器?

目标检测不仅是要对目标进行识别,还要完成定位任务,所以最终获得的bounding-box也决定了目标检测的精度(定位精度可以用算法得出的物体检测框与实际标注的物体边界框的IoU值来近似表示)。

如下图所示,绿色框为实际标准的卡宴车辆框,即Ground Truth;黄色框为selective search算法得出的建议框,即Region Proposal。即使黄色框中物体被分类器识别为卡宴车辆,但是由于绿色框和黄色框IoU值并不大,所以最后的目标检测精度并不高。采用回归器是为了对建议框进行校正,使得校正后的Region Proposal与selective search更接近, 以提高最终的检测精度。

如何设计回归器(Bounding-box regression)?

如下图所示,黄色框口P表示建议框Region Proposal,绿色窗口G表示实际框Ground Truth,红色窗口表示Region Proposal进行回归后的预测窗口。现在的目标是:找到P的线性变换【当Region Proposal与Ground Truth的IoU > 0.6时,可以认为是线性变换】,使得与G越相近,这就相当于一个可以用最小二乘法解决的线性回归问题。

P窗口的数学表达式: ,其中表示第

,其中表示第i个窗口的中心点坐标, 分别为第

分别为第i个窗口的宽和高

G窗口的数学表达式为: 。

。

定义四种变换函数 和

和 (即,通过平移对

(即,通过平移对x和y进行变化,通过缩放对w和h进行变化):

每一个函数 【

【 表示

表示 中的一个】都是一个AlexNet CNN网络的

中的一个】都是一个AlexNet CNN网络的 层特征(用

层特征(用 表示)的线性函数。所以有

表示)的线性函数。所以有 ,其中,

,其中, 为可学习模型参数(learnable

为可学习模型参数(learnable

model parameters)的向量,它就是所需要学习的回归参数。

损失函数(使用岭回归)为:

损失函数中加入正则项是为了避免归回参数过大。其中,回归目标( )由训练输入对按下式计算得来:

)由训练输入对按下式计算得来:

回归的整体过程为:

- 构造样本对。为了提高每类样本框回归的有效性,对每类样本都仅仅采集与Ground Truth相交

IoU最大的Region Proposal,并且IoU > 0.6的Region Proposal作为样本对,一共产生20对样本对【20个类别】 - 每种类型的回归器进行单独训练,输入该类型样本对

N个以及其所对应的AlexNet CNN网络 层特征

层特征 - 利用

(6)-(9)式和输入样本对进行计算 - 根据损失函数

(5)进行回归,得到使损失函数最小的参数

4. SVM训练

这是一个二分类问题,我么假设要检测车辆。只有当bounding box把整量车都包含在内,那才叫正样本;如果bounding box 没有包含到车辆,那么就可以把它当做负样本。

但问题是当检测窗口只有部分包含物体,那该怎么定义正负样本呢?通过训练发现,如果选择IoU阈值为0.3效果最好,即当重叠度小于0.3的时候,就把它标注为负样本。一旦CNN f7层特征被提取出来,那么将为每个物体累训练一个SVM分类器。当用CNN提取2000个候选框,可以得到2000×4096的特征向量矩阵,然后只需要把这样的一个矩阵与SVM权值矩阵4096×N点乘(N为分类类别数目,因为训练的N个SVM,每个SVM包含了4096个W),就可以得到结果。

图片分类标注好的训练数据非常多,但是物体检测的标注数据却很少,如何用少量的标注数据,训练高质量的模型,这就是RCNN最大的特点。其采用了迁移学习的思想:先利用ILSVRC2012这个训练数据库(一个图片分类训练数据库,其拥有大量的标注数据,共包含了1000种类别物体),进行网络的图片分类训练。因此,预训练阶段CNN模型的输出是1000个神经元,或者也可以直接采用Alexnet训练好的模型参数。

扩展阅读:

Faster RCNN

经过 R-CNN 和 Fast RCNN 的积淀,Ross B. Girshick 在 2016 年提出了新的 Faster RCNN,在结构上,Faster RCNN 已经将特征抽(feature extraction),proposal 提取,bounding box regression(rect refine),classification 都整合在了一个网络中,使得综合性能有较大提高,在检测速度方面尤为明显。

依作者看来,如上图,Faster RCNN 其实可以分为 4 个主要内容:

- Conv layers。作为一种 CNN 网络目标检测方法,Faster RCNN 首先使用一组基础的

conv + relu + pooling层提取 image 的 feature maps。该 feature maps 被共享用于后续 RPN 层和全连接层。 - Region Proposal Networks。RPN 网络用于生成 region proposals。该层通过 softmax 判断 anchors 属于 foreground 或者 background,再利用 bounding box regression 修正 anchors 获得精确的 proposals。

- Roi Pooling。该层收集输入的 feature maps 和 proposals,综合这些信息后提取 proposal feature maps,送入后续全连接层判定目标类别。

- Classification。利用 proposal feature maps 计算 proposal 的类别,同时再次 bounding box regression 获得检测框最终的精确位置。

所以本文以上述 4 个内容作为切入点介绍 Faster R-CNN 网络。下图展示了Python 版本中的 VGG16 模型中的 faster_rcnn_test.py 的网络结构,可以清晰的看到该网络对于一副任意大小 PxQ 的图像:

- 首先缩放至固定大小

MxN,然后将MxN图像送入网络 - 而 Conv layers 中包含了

13个conv层 +13个relu层 +4个pooling层 - RPN 网络首先经过

3x3卷积,再分别生成 foreground anchors 与 bounding box regression 偏移量,然后计算出 proposals - 而 Roi Pooling 层则利用 proposals 从 feature maps 中提取 proposal feature 送入后续全连接和 softmax 网络作 classification(即分类 proposal 到底是什么 object)

1. Conv layers

Conv layers 包含了 conv,pooling,relu 三种层。以 Python版本中的 VGG16 模型中的 faster_rcnn_test.py 的网络结构为例,如上图。Conv layers 部分共有 13 个 conv 层,13 个 relu 层,4 个 pooling 层。在 Conv layers 中:

- 所有的

conv层为:kernel_size = 3padding = 1stride = 1

- 所有的

pooling层为:kernel_size = 2padding = 0stride = 2

在 Faster RCNN Conv layers 中对所有的卷积都做了扩边处理( padding=1,即填充一圈 0),导致原图变为 (M+2)x(N+2) 大小,再做 3x3 卷积后输出 MxN。正是这种设置,导致 Conv layers 中的 conv 层不改变输入和输出矩阵大小。如下图所示:

类似的是,Conv layers 中的 pooling 层 kernel_size=2,stride=2。这样,·每个经过 pooling 层的 MxN 矩阵,都会变为 (M/2)x(N/2) 大小。综上所述,在整个 Conv layers 中,conv 和 relu 层不改变输入输出大小,只有 pooling 层使输出长宽都变为输入的 1/2。

那么,一个 MxN 大小的矩阵经过 Conv layers 固定变为 (M/16)x(N/16)。这样 Conv layers 生成的 feature map 中都可以和原图对应起来。

2. Region Proposal Networks(RPN)

经典的检测方法生成检测框都非常耗时,如 OpenCV adaboost 使用滑动窗口 + 图像金字塔生成检测框;或如 R-CNN 使用 SS(Selective Search)方法生成检测框。而 Faster RCNN 则抛弃了传统的滑动窗口和 SS 方法,直接使用 RPN 生成检测框,这也是 Faster R-CNN 的巨大优势,能极大提升检测框的生成速度。

上图展示了 RPN 网络的具体结构。可以看到 RPN 网络实际分为两条线:

- 上面一条通过 softmax 分类 anchors 获得 foreground 和 background(检测目标是 foreground)

- 下面一条用于计算对于 anchors 的 bounding box regression 偏移量,以获得精确的 proposal。

最后的 Proposal 层则负责综合 foreground anchors 和 bounding box regression 偏移量获取 proposals,同时剔除太小和超出边界的 proposals。其实整个网络到了 Proposal Layer 这里,就完成了相当于目标定位的功能。

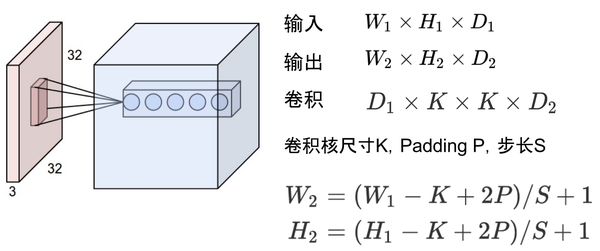

2.1 多通道图像卷积基础知识介绍

- 对于单通道图像+单卷积核做卷积,比较简单。

- 对于多通道图像+多卷积核做卷积,计算方式如下:

如上图,输入有 3 个通道,同时有 2 个卷积核。对于每个卷积核,先在输入 3 个通道分别作卷积,再将 3 个通道结果加起来得到卷积输出。所以对于某个卷积层,无论输入图像有多少个通道,输出图像通道数总是等于卷积核数量。

对多通道图像做 1x1 卷积,其实就是将输入图像于每个通道乘以卷积系数后加在一起,即相当于把原图像中本来各个独立的通道“联通”在了一起。

2.2 anchors

与 RPN 网络密切相关的是 anchors。anchors,实际上就是一组由rpn/generate_anchors.py 生成的矩形。直接运行作者 demo 中的 generate_anchors.py 可以得到以下输出:

其中每行的 4 个值  表矩形左上和右下角点坐标。

表矩形左上和右下角点坐标。9 个矩形共有 3 种形状,长宽比为大约为:  三种,如下图。实际上通过 anchors 就引入了检测中常用到的多尺度方法。

三种,如下图。实际上通过 anchors 就引入了检测中常用到的多尺度方法。

注:关于上面的 anchors size,其实是根据检测图像设置的。在 Python demo 中,会把任意大小的输入图像 reshape 成 800x600(即之前图中的M=800,N=600)。再回头来看 anchors 的大小,anchors 中长宽 1:2 中最大为 352x704,长宽 2:1 中最大 736x384,基本是 cover 了 800x600 的各个尺度和形状。

那么这 9 个 anchors 是做什么的呢?借用 Faster RCNN 论文中的原图,如图7,遍历 Conv layers 计算获得的 feature maps,为每一个点都配备这 9 种 anchors 作为初始的检测框。这样做获得检测框很不准确,不用担心,后面还有 2 次 bounding box regression 可以修正检测框位置。

解释一下上面这张图的数字:

- 在原文中使用的是 ZF model 中,其 Conv Layers 中最后的

conv5层num_output=256,对应生成256张特征图,所以相当于 feature map 每个点都是256-dimensions - 在

conv5之后,做了rpn_conv/3x3卷积且num_output=256,相当于每个点又融合了周围3x3的空间信息(猜测这样做也许更鲁棒?反正我没测试),同时256-d不变 - 假设在

conv5feature map 中每个点上有k个 anchor(默认k=9),而每个 anchor 要分 foreground 和 background,所以每个点由256dfeature 转化为cls=2k scores;而每个 anchor 都有(x, y, w, h)对应4个偏移量,所以reg=4k coordinates - 补充一点,全部 anchors 拿去训练太多了,训练程序会在合适的 anchors 中随机选取

128个 positive anchors +128个negative anchors 进行训练(什么是合适的 anchors 下文解释)

注意,在本文使用的 VGG conv5 num_output=512,所以是 512d,其他类似。

其实 RPN 最终就是在原图尺度上,设置了密密麻麻的候选 anchor。然后用 CNN 去判断哪些 anchor是里面有目标的 foreground anchor,哪些是没目标的 background。所以,仅仅是个二分类而已。

那么 anchor 一共有多少个?原图 800x600,VGG 下采样 16 倍,feature map 每个点设置 9 个 anchor,所以:

其中 ceil() 表示向上取整,是因为 VGG 输出的 feature map size= 50*38。

2.3 softmax 判定 foreground 与 background

一副 MxN 大小的矩阵送入 Faster RCNN 网络后,到 RPN 网络变为 (M/16)x(N/16),不妨设 W=M/16,H=N/16。在进入 reshape 与 softmax 之前,先做了 1x1 卷积,如下图:

该 1x1 卷积的 caffe prototxt 定义如下:

layer {

name: "rpn_cls_score"

type: "Convolution"

bottom: "rpn/output"

top: "rpn_cls_score"

convolution_param {

num_output: 18 # 2(bg/fg) * 9(anchors)

kernel_size: 1 pad: 0 stride: 1

}

}

可以看到其 num_output=18,也就是经过该卷积的输出图像为 WxHx18 大小。这也就刚好对应了 feature maps 每一个点都有 9 个 anchors,同时每个 anchors 又有可能是 foreground 和 background,所有这些信息都保存 WxHx(9*2) 大小的矩阵。

为何这样做?后面接 softmax 分类获得 foreground anchors,也就相当于初步提取了检测目标候选区域 box(一般认为目标在 foreground anchors 中)。

那么为何要在 softmax 前后都接一个 reshape layer?其实只是为了便于 softmax 分类,至于具体原因这就要从 caffe 的实现形式说起了。在 caffe 基本数据结构 blob 中以如下形式保存数据:

blob=[batch_size, channel,height,width]

对应至上面的保存 bg/fg anchors的矩阵,其在 caffe blob 中的存储形式为 [1, 2x9, H, W]。而在 softmax 分类时需要进行 fg/bg 二分类,所以 reshape layer 会将其变为 [1, 2, 9xH, W] 大小,即单独“腾空”出来一个维度以便 softmax 分类,之后再 reshape 回复原状。贴一段 caffe softmax_loss_layer.cpp 的 reshape 函数的解释,非常精辟:

"Number of labels must match number of predictions; "

"e.g., if softmax axis == 1 and prediction shape is (N, C, H, W), "

"label count (number of labels) must be N*H*W, "

"with integer values in {0, 1, ..., C-1}.";

综上所述,RPN 网络中利用 anchors 和 softmax 初步提取出 foreground anchors 作为候选区域。

2.4 bounding box regression 原理

目标检测中 region proposal 的作用?

1. 理由一

以 Faster RCNN 举例。在 Faster RCNN 里面,anchor(或者说 RPN 网络)的作用是代替以往 RCNN 使用的 selective search 的方法寻找图片里面可能存在物体的区域。当一张图片输入 Resnet 或者 VGG,在最后一层的 feature map 上面,寻找可能出现物体的位置,这时候分别以这张 feature map 的每一个点为中心,在原图上画出 9 个尺寸不一的 anchor。然后计算 anchor 与GT(ground truth) box 的 IoU(重叠率),满足一定 IoU 条件的 anchor,便认为是这个 anchor 包含了某个物体。

目标检测的思想是,首先在图片中寻找“可能存在物体的位置(regions)”,然后再判断“这个位置里面的物体是什么东西”,所以region proposal就参与了判断物体可能存在位置的过程。

region proposal 是让模型学会去看哪里有物体,GT box 就是给它进行参考,告诉它是不是看错了,该往哪些地方看才对。

2. 理由二

首先明确一个定义,当前主流的 Object Detection 框架分为 one-stage 和 two-stage,而 two-stage 多出来的这个 stage 就是 Regional Proposal 过程。

Regional Proposal的输出到底是什么?以 Faster R-CNN 为代表的 two-stage 目标检测方法为例:

可以看到,图中有两个 Classification loss 和两个 Bounding-box regression loss,有什么区别呢?

- Input Image 经过 CNN 特征提取,首先来到 Region Proposal 网络。由 Region Proposal Network 输出的Classification,这并不是判定物体在 COCO 数据集上对应的

80类中哪一类,而是输出一个二进制值p,可以理解为,人工设定一个

threshold=0.5。 - RPN 网络做的事情就是,如果一个 Region 的

,则认为这个 Region 中可能是

80个类别中的某一类,具体是哪一类现在还不清楚。到此为止,Network 只需要把这些可能含有物体的区域选取出来就可以了,这些被选取出来的 Region 又叫做 ROI (Region of Interests),即感兴趣的区域。当然了,RPN 同时也会在 feature map 上框定这些 ROI 感兴趣区域的大致位置,即输出 Bounding-box。

所以,RPN 网络做的事情就是,把一张图片中不感兴趣的区域—花花草草、大马路、天空之类的区域忽视掉,只留下一些可能感兴趣的区域—车辆、行人、水杯、闹钟等等,然后之后只需要关注这些感兴趣的区域,进一步确定它到底是车辆、还是行人、还是水杯(分类问题)等。到此为止,RPN 网络的工作就完成了,即我们现在得到的有:在输入 RPN 网络的 feature map 上,所有可能包含 80 类物体的 Region 区域的信息,其他 Region(非常多)可以直接不考虑了(不用输入后续网络)。

接下来的工作就很简单了,假设输入 RPN 网络的 feature map 大小为 ,那么提取的 ROI 的尺寸一定小于

,因为原始图像某一块的物体在 feature map 上也以同样的比例存在。只需要把这些 Region 从 feature map 上抠出来,由于每个 Region 的尺寸可能不一样,因为原始图像上物体大小不一样,所以我们需要将这些抠出来的 Region 想办法 resize 到相同的尺寸,这一步方法很多(Pooling 或者 Interpolation,一般采用 Pooling,因为反向传播时求导方便)。

假设这些抠出来的 ROI Region 被 resize 到了 或者

,那接下来将这些 Region 输入普通的分类网络,即第一张 Faster R-CNN 的结构图中最上面的部分,即可得到整个网络最终的输出 classification,这里的 class(车、人、狗 ……)才真正对应了 COCO 数据集

80 类中的具体类别。

同时,由于之前 RPN 确定的 box\region 坐标比较粗略,即大概框出了感兴趣的区域,所以这里再来一次精确的微调,根据每个 box 中的具体内容微微调整一下这个 box的坐标,即输出第一张图中右上方的 Bounding-box regression。

总结

Region Proposal有什么作用?

- COCO 数据集上总共只有

80类物体,如果不进行 Region Proposal,即网络最后的 classification 是对所有 anchor 框定的 Region 进行识别分类,会严重拖累网络的分类性能,难以收敛。原因在于,存在过多的不包含任何有用的类别(80类之外的,例如各种各样的天空、草地、水泥墙、玻璃反射等等)的 Region 输入分类网络,而这些无用的 Region 占了所有 Region 的很大比例。换句话说,这些 Region 数量庞大,却并不能为 softmax 分类器带来有用的性能提升(因为无论怎么预测,其类别都是背景,对于主体的80类没有贡献)。 - 大量无用的 Region 都需要单独进入分类网络,而分类网络由几层卷积层和最后一层全连接层组成,参数众多,十分耗费计算时间,Faster R-CNN 本来就不能做到实时,这下更慢了。

SPP Net

出自 2015 年发表在 IEEE 上的论文—《Spatial Pyramid Pooling in Deep Convolutional Networks for Visual Recognition》

在此之前,所有的神经网络都是需要输入固定尺寸的图片,比如 224x224(AlexNet)、32x32(LeNet)、96x96 等。这样对于希望检测各种大小的图片的时候,需要经过 crop,或者 war p等一系列操作,这都在一定程度上导致图片信息的丢失和变形,限制了识别精确度。

RCNN 的弊端

RCNN 使用 CNN 作为特征提取器,首次使得目标检测跨入深度学习的阶段。但是 RCNN 对于每一个区域候选都需要首先将图片放缩到固定的尺寸(224x224),然后为每个区域候选提取 CNN 特征。容易看出这里面存在的一些性能瓶颈:

- 速度瓶颈:重复为每个 region proposal 提取特征是极其费时的,Selective Search 对于每幅图片产生

2K左右个 region proposal,也就是意味着一幅图片需要经过2K次的完整的 CNN 计算得到最终的结果。 - 性能瓶颈:对于所有的 region proposal 防缩到固定的尺寸会导致我们不期望看到的几何形变,而且由于速度瓶颈的存在,不可能采用多尺度或者是大量的数据增强去训练模型。

在 RCNN 中 CNN 阶段的流程大致如下(红色框是 selective search 输出的可能包含物体的候选框(ROI)):

上面这个图可以看出SPP Net 和 RCNN 的区别,首先是输入不需要放缩到指定大小。其次是增加了一个空间金字塔池化层,还有最重要的一点是每幅图片只需要提取一次特征。

为什么要固定输入图片的大小?

卷积层的参数和输入大小无关,它仅仅是一个卷积核在图像上滑动,不管输入图像多大都没关系,只是对不同大小的图片卷积出不同大小的特征图,但是全连接层的参数就和输入图像大小有关,因为它要把输入的所有像素点连接起来,需要指定输入层神经元个数和输出层神经元个数,所以需要规定输入的 feature 的大小。因此,固定长度的约束仅限于全连接层(作为全连接层,如果输入的 x 维数不等,那么参数 w 肯定也会不同。因此,全连接层是必须确定输入,输出个数的)。

一张图图片会有大约 2k 个候选框,每一个都要单独输入 CNN 做卷积等操作很费时。SPP Net 提出:能否在 feature map 上提取 ROI 特征,这样就只需要在整幅图像上做一次卷积。SPP Net 在最后一个卷积层后,接入了金字塔池化层,使用这种方式,可以让网络输入任意的图片,而且还会生成固定大小的输出。

何凯明团队的 SPP Net 给出的解决方案是,既然只有全连接层需要固定的输入,那么我们在全连接层前加入一个网络层,让他对任意的输入产生固定的输出不就好了吗?一种常见的想法是对于最后一层卷积层的输出 pooling 一下,但是这个 pooling 窗口的尺寸及步伐设置为相对值,也就是输出尺寸的一个比例值,这样对于任意输入经过这层后都能得到一个固定的输出。SPP Net 在这个想法上继续加入 SPM 的思路,SPM 其实在传统的机器学习特征提取中很常用,主要思路就是对于一副图像分成若干尺度的一些块,比如一幅图像分成 1 份,4 份,8 份等。然后对于每一块提取特征然后融合在一起,这样就可以兼容多个尺度的特征啦。SPP Net 首次将这种思想应用在 CNN 中,对于卷积层特征我们也先给他分成不同的尺寸,然后每个尺寸提取一个固定维度的特征,最后拼接这些特征不就是一个固定维度的输入了吗?

所谓空间金字塔池化就是沿着金字塔的低端向顶端一层一层做池化。

上图的空间金字塔池化层是 SPP Net 的核心,其主要目的是对于任意尺寸的输入产生固定大小的输出。思路是对于任意大小的 feature map 首先分成 16、4、1 个块,然后在每个块上最大池化,池化后的特征拼接得到一个固定维度的输出。以满足全连接层的需要。不过因为不是针对于目标检测的,所以输入的图像为一整副图像。

假设原图输入是 224x224,对于 conv5 出来后的输出是 13x13x256 的,可以理解成有 256 个这样的 filter,每个 filter 对应一张 13x13 的 response map。如果像上图那样将 response map 分成 1x1(金字塔底座),2x2(金字塔中间),4x4(金字塔顶座)三张子图,分别做 max pooling 后,出来的特征就是 (16+4+1)x256 维度。如果原图的输入不是 224x224,出来的特征依然是 (16+4+1)x256 维度。这样就实现了不管图像尺寸如何池化 n 的输出永远是 (16+4+1)x256 维度。

实际运用中只需要根据全连接层的输入维度要求设计好空间金字塔即可。

网络细节

1. 卷积层特征图

SPP Net 通过可视化 conv5 层特征,发现卷积特征其实保存了空间位置信息(数学推理中更容易发现这点),并且每一个卷积核负责提取不同的特征,比如 C 图 175、55 卷积核的特征,其中 175 负责提取窗口特征,55 负责提取圆形的类似于车轮的特征。我们可以通过传统的方法聚集这些特征,例如词袋模型或是空间金字塔的方法。

2. 空间金字塔池化(Spatial Pyramid Pooling)

虽然总体流程还是 Selective Search 得到候选区域 —> CNN 提取ROI 特征 —> 类别判断 —> 位置精修,但是由于所有 ROI 的特征直接在 feature map 上提取,大大减少了卷积操作,提高了效率。

有两个难点要解决:

- 原始图像的 ROI 如何映射到特征图(feature map,一系列卷积层的最后输出)

- ROI 的在特征图上的对应的特征区域的维度不满足全连接层的输入要求怎么办(又不可能像在原始 ROI 图像上那样进行截取和缩放)?

对于难点 2:

- 这个问题涉及的流程主要有:图像输入

—>卷积层1—>池化1—>…—>卷积层n—>池化n—>全连接层。 - 引发问题的原因主要有:全连接层的输入维度是固定死的,导致池化

n的输出必须与之匹配,继而导致图像输入的尺寸必须固定。

为了使一些列卷积层的最后输出刚维度好是全连接层的输入维度,解决方法可能有:

- 想办法让不同尺寸的图像也可以使池化

n产生固定的 输出维度(打破图像输入的固定性) - 想办法让全连接层可以接受非固定的输入维度(打破全连接层的固定性,继而也打破了图像输入的固定性)

以上的方法 1 就是 SPP Net 的思想。它在池化 n 的地方做了一些手脚(特殊池化手段:空间金字塔池化),使得不同尺寸的图像也可以使池化 n 产生固定的输出维度。至于方法 2,其实就是全连接转换为全卷积,作用的效果等效为在原始图像做滑窗,多个窗口并行处理)

3. SPP Net应用于图像分类

SPP Net 的能够接受任意尺寸图片的输入,但是训练难点在于所有的深度学习框架都需要固定大小的输入,因此 SPP Net 做出了多阶段多尺寸训练方法。在每一个 epoch 的时候,我们先将图像放缩到一个 size,然后训练网络。训练完整后保存网络的参数,然后 resize 到另外一个尺寸,并在之前权值的基础上再次训练模型。相比于其他的 CNN 网络,SPP Net 的优点是可以方便地进行多尺寸训练,而且对于同一个尺度,其特征也是个空间金字塔的特征,综合了多个特征的空间多尺度信息。

4. SPP Net 应用于目标检测

SPP Net 理论上可以改进任何 CNN 网络,通过空间金字塔池化,使得 CNN 的特征不再是单一尺度的。但是 SPP Net 更适用于处理目标检测问题,首先是网络可以介绍任意大小的输入,也就是说能够很方便地多尺寸训练。其次是空间金字塔池化能够对于任意大小的输入产生固定的输出,这样使得一幅图片的多个 region proposal 提取一次特征成为可能。SPP Net 的做法是:

首先通过 selective search 产生一系列的 region proposal

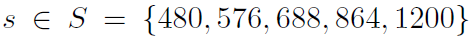

然后训练多尺寸识别网络用以提取区域特征,其中处理方法是每个尺寸的最短边大小在尺寸集合中:

训练的时候通过上面提到的多尺寸训练方法,也就是在每个 epoch 中首先训练一个尺寸产生一个 model,然后加载这个 model 并训练第二个尺寸,直到训练完所有的尺寸。空间金字塔池化使用的尺度为:

1x1,2x2,3x3,6x6,一共是50个bins。

- 在测试时,每个 region proposal 选择能使其包含的像素个数最接近

224x224的尺寸,提取相 应特征。

由于我们的空间金字塔池化可以接受任意大小的输入,因此对于每个region proposal将其映射到feature map上,然后仅对这一块feature map进行空间金字塔池化就可以得到固定维度的特征用以训练CNN了。关于从region proposal映射到feature map的细节我们待会儿去说。

- 训练 SVM,bounding box 回归

5. 如何从一个 region proposal 映射到 feature map 的位置?

SPP Net 通过角点尽量将图像像素映射到 feature map 感受野的中央,假设每一层的 padding 都是 p/2(p为卷积核大小)。对于 feature map 的一个像素 (x',y'),其实际感受野为:(Sx‘,Sy’),其中 S 为之前所有层步伐的乘积。然后对于 region proposal 的位置,我们获取左上右下两个点对应的 feature map 的位置,然后取特征就好了。左上角映射为:

右下角映射为:

当然,如果 padding 大小不一致,那么就需要计算相应的偏移值啦。

金字塔池化的意义

总结而言,当网络输入的是一张任意大小的图片,这个时候可以一直进行卷积、池化,直到网络的倒数几层的时候,也就是即将与全连接层连接的时候,就要使用金字塔池化,使得任意大小的特征图都能够转换成固定大小的特征向量,这就是空间金字塔池化的意义(多尺度特征提取出固定大小的特征向量)。

SPP Net & RCNN

对于 RCNN,整个过程是:

- 首先通过 Selective Search,对待检测的图片进行搜索出大约

2000个候选窗口。 - 把这

2k个候选窗口的图片都缩放到227x227,然后分别输入 CNN 中,每个 proposal 提取出一个特征向量,也就是说利用 CNN 对每个 proposal 进行提取特征向量。 - 把上面每个候选窗口的对应特征向量,利用 SVM 算法进行分类识别。

可以看出 RCNN 的计算量是非常大的,因为 2k 个候选窗口都要输入到 CNN 中,分别进行特征提取。

而对于 SPP Net,整个过程是:

- 首先通过 Selective Search,对待检测的图片进行搜索出

2000个候选窗口。这一步和 RCNN 一样。 - 特征提取阶段。这一步就是和 RCNN 最大的区别了,这一步骤的具体操作如下:把整张待检测的图片,输入 CNN 中,进行一次性特征提取,得到 feature maps,然后在 feature maps 中找到各个候选框的区域,再对各个候选框采用金字塔空间池化,提取出固定长度的特征向量。而 RCNN 输入的是每个候选框,然后在进入 CNN,因为 SPP Net 只需要一次对整张图片进行特征提取,速度会大大提升。

- 最后一步也是和 RCNN 一样,采用 SVM 算法进行特征向量分类识别。

AlexNet

1. 模型结构

如上图所示,采用是两台GPU服务器,所有会有两个流程图。该模型一共分为 8 层——5 个卷积层,3 个全连接层(卷积层后面加了最大池化层),包含 6 亿 3000 万个连接,6000 万个参数和 65 万个神经元。在每一个卷积层中,包含了激励函数 ReLU 以及局部响应归一化(LRN)处理,然后再经过降采样(pooling 处理)。

2. 具体结构

整个网络共有 8 个需要训练的层,前 5 个为卷积层,最后 3 层为全连接层。

第一层:卷积层(conv1)

- 输入图片大小为:

224×224×3(经过预处理后实际大小变为227×227×3) - 卷积核:

11×11×3;步长:4;数量:96(图中为48个是由于采用了2` 个 GPU。由于卷积核的深度与图像深度一样,所以提取到的特征也是彩色的) - 卷积后的数据:

55×55×96【(227-11+1)/4 = 55(向上取整)】 relu1后的数据:55×55×96- 最大池化层

pool1的核:3×3;步长:2。因此输出的尺寸为:(227-11+1)/4 = 55(向上取整) pool1后的数据(降采样):27×27×96【(55-3+1)/2 = 27】- 局部归一化 LRN

norm1:local_size = 5(归一化运算的尺度为5×5) - 输出:

27×27×96。

第二层:卷积层(conv2)

- 输入数据:

27×27×96 - 卷积核:

5×5×96;步长:1;数量:256 - 卷积后的数据:

27×27×256(SAME padding,使得卷积后图像大小不变) relu2后的数据:27×27×256pool2的核(最大池化):3×3;步长:2pool2后的数据:13×13×256【(27-3+1)/2 = 13】norm2:local_size = 5- 输出:

13×13×256

第三层:卷积层(conv3)

- 输入数据:

13×13×256 - 卷积核:

3×3;步长:1;数量:384 - 卷积后数据:

13×13×384(SAME padding) relu3后的数据:13×13×384- 输出:

13×13×384

conv3 层没有 max pool 层和 norm 层。

第四层:卷积层(conv4)

- 输入数据:

13×13×384 - 卷积核:

3×3;步长:1;数量:384 - 卷积后数据:

13×13×384(SAME padding) relu4后的数据:13×13×384- 输出:

13×13×384

conv4 层也没有 max pool 层和 norm 层。

第五层:卷积层(conv5)

- 输入数据:

13×13×384 - 卷积核:

3×3;步长:1;数量:256 - 卷积后数据:

13×13×256(SAME padding) relu5后的数据:13×13×256pool5的核:3×3;步长:2pool5后的数据:6×6×256【(13-3+1)/2 = 6】- 输出:

6×6×256

conv5 层有 max pool,没有 norm 层

第六层:全连接层(fc6)

- 输入数据:

6×6×256 - 全连接输出:

4096×1 relu6后的数据:4096×1dropout6后数据:4096×1- 输出:

4096×1

第七层:全连接层(fc7)

- 输入数据:

4096×1 - 全连接输出:4096×1

relu7后的数据:4096×1dropout7后数据:4096×1- 输出:

4096×1

第八层:全连接层(fc8)

- 输入数据:

4096×1 - 全连接输出:

1000 - 输出一千种分类的概率

Alexnet 网络定义如下(alexnet_inference.py):

import tensorflow as tf

def print_layers(layer):

print(layer.op.name, ' ', layer.get_shape().as_list())

def inference(input_tensor, keep_prob, num_classes):

# conv1

with tf.name_scope('conv1'):

conv1_weights = tf.get_variable(

'weight1',

[11, 11, 3, 96],

initializer=tf.truncated_normal_initializer(stddev=0.1)

)

conv1_biases = tf.get_variable(

'bias1',

[96],

initializer=tf.constant_initializer(0.)

)

conv1 = tf.nn.conv2d(

input_tensor,

conv1_weights,

strides=[1, 4, 4, 1],

padding='VALID'

)

relu1 = tf.nn.relu(tf.nn.bias_add(conv1, conv1_biases))

pool1 = tf.nn.max_pool(

relu1,

ksize=[1, 3, 3, 1],

strides=[1, 2, 2, 1],

padding='VALID'

)

norm1 = tf.nn.lrn(pool1, depth_radius=4, bias=1, alpha=1e-3/9, beta=0.75, name='norm1')

# conv2

with tf.name_scope('conv2'):

conv2_weights = tf.get_variable(

'weight2',

[5, 5, 96, 256],

initializer=tf.truncated_normal_initializer(stddev=0.1)

)

conv2_biases = tf.get_variable(

'bias2',

[256],

initializer=tf.constant_initializer(0.)

)

conv2 = tf.nn.conv2d(

norm1,

conv2_weights,

strides=[1, 1, 1, 1],

padding='SAME'

)

relu2 = tf.nn.relu(tf.nn.bias_add(conv2, conv2_biases))

pool2 = tf.nn.max_pool(

relu2,

ksize=[1, 3, 3, 1],

strides=[1, 2, 2, 1],

padding='VALID'

)

norm2 = tf.nn.lrn(pool2, depth_radius=4, bias=1, alpha=1e-3/9, beta=0.75, name='norm1')

# conv3

with tf.name_scope('conv3'):

conv3_weights = tf.get_variable(

'weight3',

[3, 3, 256, 384],

initializer=tf.truncated_normal_initializer(stddev=0.1)

)

conv3_biases = tf.get_variable(

'bias3',

[384],

initializer=tf.constant_initializer(0.)

)

conv3 = tf.nn.conv2d(

pool2,

conv3_weights,

strides=[1, 1, 1, 1],

padding='SAME'

)

relu3 = tf.nn.relu(tf.nn.bias_add(conv3, conv3_biases))

# conv4

with tf.name_scope('conv4'):

conv4_weights = tf.get_variable(

'weight4',

[3, 3, 384, 384],

initializer=tf.truncated_normal_initializer(stddev=0.1)

)

conv4_biases = tf.get_variable(

'bias4',

[384],

initializer=tf.constant_initializer(0.)

)

conv4 = tf.nn.conv2d(

relu3,

conv4_weights,

strides=[1, 1, 1, 1],

padding='SAME'

)

relu4 = tf.nn.relu(tf.nn.bias_add(conv4, conv4_biases))

# conv5

with tf.name_scope('conv5'):

conv5_weights = tf.get_variable(

'weight5',

[3, 3, 384, 256],

initializer=tf.truncated_normal_initializer(stddev=0.1)

)

conv5_biases = tf.get_variable(

'bias5',

[256],

initializer=tf.constant_initializer(0.)

)

conv5 = tf.nn.conv2d(

relu4,

conv5_weights,

strides=[1, 1, 1, 1],

padding='SAME'

)

relu5 = tf.nn.relu(tf.nn.bias_add(conv5, conv5_biases))

pool5 = tf.nn.max_pool(

relu5,

ksize=[1, 3, 3, 1],

strides=[1, 2, 2, 1],

padding='VALID'

)

# fc6

with tf.name_scope('fc6'):

flattened = tf.reshape(pool5, shape=[-1, 6*6*256])

weights = tf.Variable(tf.truncated_normal(

[6*6*256, 4096],

dtype=tf.float32,

stddev=1e-1), name='weights')

biases = tf.Variable(tf.constant(0., shape=[4096], dtype=tf.float32),

name='biases')

relu6 = tf.nn.relu(tf.nn.xw_plus_b(flattened, weights, biases))

dropout6 = tf.nn.dropout(relu6, keep_prob)

# fc7

with tf.name_scope('fc7'):

weights = tf.Variable(tf.truncated_normal(

[4096, 4096],

dtype=tf.float32,

stddev=1e-1), name='weights')

biases = tf.Variable(tf.constant(0., shape=[4096], dtype=tf.float32),

name='biases')

relu7 = tf.nn.relu(tf.nn.xw_plus_b(dropout6, weights, biases))

dropout7 = tf.nn.dropout(relu7, keep_prob)

with tf.name_scope('fc8'):

weights = tf.Variable(tf.truncated_normal(

[4096, num_classes],

dtype=tf.float32,

stddev=1e-1), name='weights')

biases = tf.Variable(tf.constant(0., shape=[num_classes], dtype=tf.float32),

name='biases')

fc8 = tf.nn.xw_plus_b(dropout7, weights, biases)

return fc8

Alexnet 网络的训练过程(alexnet_train.py):

import os

import numpy as np

import tensorflow as tf

import alexnet_inference

import glob

from datetime import datetime

# 配置神经网络的参数

TRAIN_BATCH_SIZE = 10

TEST_BATCH_SIZE = 10

LEARNING_RATE = 1e-3

DROPOUT_RATE = 0.25

NUM_CLASSES = 2 # 类别标签

NUM_EPOCHS = 10

# 模型保存的路径和文件名

MODEL_SAVE_PATH = "model/"

MODEL_NAME = "model.ckpt"

TENSORBOARD_PATH = "tensorboard/" # 存储tensorboard文件

TOTAL_DATASET = 'train/'

TRAIN_DATASET_PATH = ['train/cat/',

'train/dog/']

TEST_DATASET_PATH = ['test/']

LABEL = ['cat',

'dog']

# 将图像转换为三维数据,将标签转换为one-hot形式

def parse_image(file_name, label):

image_string = tf.read_file(file_name)

image_decoded = tf.image.decode_jpeg(image_string, channels=3)

image_resized = tf.image.resize_images(image_decoded, [227, 227]) # 将图片居中

image_centered = tf.subtract(image_resized, [123.68, 116.779, 103.939])

image = image_centered[:, :, ::-1] # 将RGB转换为BGR

label = tf.one_hot(label, NUM_CLASSES)

return image, label

# 打乱图片顺序

def shuffle_images(train_images, train_labels):

permutation = np.random.permutation(len(train_labels))

images = []

labels = []

for i in permutation:

images.append(train_images[i])

labels.append(train_labels[i])

return images, labels

# 将图片和标签先转化为tensor,再创建Dataset,

def process_image(train_images, train_labels):

image_num = len(train_images)

train_images = tf.convert_to_tensor(train_images, dtype=tf.string)

train_labels = tf.convert_to_tensor(train_labels, dtype=tf.int32)

dataset = tf.data.Dataset.from_tensor_slices((train_images, train_labels))

dataset = dataset.map(parse_image).batch(TRAIN_BATCH_SIZE)

return dataset, image_num

def train():

if not os.path.isdir(MODEL_SAVE_PATH):

os.mkdir(MODEL_SAVE_PATH)

if not os.path.isdir(TOTAL_DATASET):

os.mkdir(TOTAL_DATASET)

if not os.path.isdir(list(TRAIN_DATASET_PATH)[0]) or not os.path.isdir(list(TRAIN_DATASET_PATH)[1]):

os.mkdir(list(TRAIN_DATASET_PATH)[0])

os.mkdir(list(TRAIN_DATASET_PATH)[1])

# 处理训练集图片

train_images = []

train_labels = []

for path in TRAIN_DATASET_PATH:

train_images[len(train_images): len(train_images)] = np.array(glob.glob(path + '*jpg')).tolist()

for path in train_images:

# file_name表示文件名

file_name = path.split('/')[-1]

for i in range(NUM_CLASSES):

if LABEL[i] in file_name:

train_labels.append(i)

break

train_images, train_labels = shuffle_images(train_images, train_labels)

train_data, train_data_size = process_image(train_images, train_labels)

# 将training的过程分为train_batches_per_epoch次迭代完成,每次迭代包含的元素为TRAIN_BATCH_SIZE个

train_batches_per_epoch = int(np.floor(train_data_size) / TRAIN_BATCH_SIZE)

train_iterator = tf.data.Iterator.from_structure(train_data.output_types, train_data.output_shapes)

train_initializer = train_iterator.make_initializer(train_data) # 创建dataset迭代器,需要进行初始化

train_next_batch = train_iterator.get_next()

# 处理测试集图片

test_images = []

test_labels = []

for path in TEST_DATASET_PATH:

test_images[len(test_images): len(test_images)] = np.array(glob.glob(path + '*jpg')).tolist()

for path in test_images:

# file_name表示文件名

file_name = path.split('/')[-1]

for i in range(NUM_CLASSES):

if LABEL[i] in file_name:

test_labels.append(i)

break

test_images, test_labels = shuffle_images(test_images, test_labels)

test_data, test_data_size = process_image(test_images, test_labels)

# 将training的过程分为train_batches_per_epoch次迭代完成,每次迭代包含的元素为TRAIN_BATCH_SIZE个

test_batches_per_epoch = int(np.floor(test_data_size) / TEST_BATCH_SIZE)

test_iterator = tf.data.Iterator.from_structure(test_data.output_types, test_data.output_shapes)

test_initializer = test_iterator.make_initializer(test_data) # 创建dataset迭代器,需要进行初始化

test_next_batch = test_iterator.get_next()

x = tf.placeholder(tf.float32, [None, 227, 227, 3])

y_ = tf.placeholder(tf.float32, [None, NUM_CLASSES])

keep_prob = tf.placeholder(tf.float32)

y = alexnet_inference.inference(x, keep_prob, NUM_CLASSES)

loss = tf.reduce_mean(tf.nn.softmax_cross_entropy_with_logits_v2(logits=y, labels=y_))

train_op = tf.train.AdamOptimizer(LEARNING_RATE).minimize(loss)

accuracy = tf.reduce_mean(tf.cast(tf.equal(tf.argmax(y, 1), tf.argmax(y_, 1)), tf.float32))

init_op = tf.global_variables_initializer()

# tensorboard

# tf.summary.scalar('loss,')

saver = tf.train.Saver()

with tf.Session() as sess:

sess.run(init_op)

print('{}: Start training...'.format(datetime.now()))

for epoch in range(NUM_EPOCHS):

sess.run(train_initializer)

print('ecpoch number: {} start'.format(epoch+1))

# train

# 200 / 10 = 20

for step in range(train_batches_per_epoch):

image_batch, label_batch = sess.run(train_next_batch)

loss_value, train_step = sess.run([loss, train_op], feed_dict={

x: image_batch,

y_: label_batch,

keep_prob: DROPOUT_RATE

})

if step % 10 ==0:

print("After %d training step(s), loss on training batch is %f." % (epoch, loss_value))

# accuracy

sess.run(test_initializer)

test_accuracy = 0

test_count = 0

for _ in range(test_batches_per_epoch):

image_batch, label_batch = sess.run(test_next_batch)

temp_accuracy = sess.run(accuracy, feed_dict={x: image_batch,

y_: label_batch,

keep_prob: 1.0})

test_accuracy += temp_accuracy

test_count += 1

try:

test_accuracy /= test_count

except:

print('ZeroDivisionError!')

print("Accuracy = {:.4f}".format(test_accuracy))

# save model

print("{}: Saving model... ".format(datetime.now()))

saver.save(sess, os.path.join(MODEL_SAVE_PATH,MODEL_NAME), global_step=epoch)

def main(argv=None):

train()

main()

# if __name__ == '__main__':

# tf.app.run()

3. 创新点

1. ReLU Nonlinearity

一般神经元的激活函数会选择 sigmoid 函数或者 tanh 函数,然而 Alex 发现在训练时间的梯度衰减方面,这些非线性饱和函数要比非线性非饱和函数慢很多。在 AlexNet 中用的非线性非饱和函数是 f=max(0,x),即 ReLU。实验结果表明,要将深度网络训练至 training error rate 达到 25% 的话,ReLU 只需 5 个 epochs 的迭代,但 tanh 需要 35 个 epochs 的迭代,用 ReLU 比 tanh 快 6 倍。

2. 双 GPU 并行运行

为提高运行速度和提高网络运行规模,采用双 GPU 的设计模式。并且规定 GPU只能在特定的层进行通信交流。其实就是每一个 GPU 负责一半的运算处理。值得注意的是,虽然 one-GPU 网络规模只有 two-GPU 的一半,但其实这两个网络其实并非等价的。

3. LRN 局部响应归一化

ZF Net

源自论文《Visualizing and Understanding Convolutional Networks 》

1. 概述

本文设计了一种可以可视化卷积层中 feature map 的系统,通过可视化每层 layer 的某些 activation 来探究 CNN 网络究竟是怎样“学习”的,同时文章通过可视化了 AlexNet 发现了因为结构问题,导致有“影像重叠”(aliasing artifacts),因此对网络进行了改进,设计出了 ZF Net。

文章通过把 activation(feature map 中的数值)映射回输入像素的空间,去了解什么样的输入模式会生成 feature map 中的一个给定activation,这个模型主要通过反卷积(deconvolution),反向池化(Unpooling)与“反向激活”(Rectification),其实就是把整个 CNN 网络倒过来,另外值得说一下的是,并不是完全倒过来,只是近似,所有的“反向”操作都是近似,主要是使得从各层 layer 的尺度还原到在原始图像中相应大小的尺度。

同时文章还分析了每层 layer 学习到了什么,以及可视化最强 activation 的演化过程来关系模型的收敛过程,同时也利用遮挡某些部位来学习 CNN 是学习 object 本身还是周围环境。

2. 可视化结构

2.1 Unpooling

要想完全还原 max pooling 是不太现实的,除非记录每一层 feature,那有些得不偿失,文章通过记录池化过程中最大激活值所在位置以及数值,在 unpooling 的时候,还原那个数值,其他的位置设为 0,从而近似“反向池化”,具体如下图:

2.2 Rectification

CNN 使用 ReLU 确保每层输出的激活之都是正数,因此对于反向过程,同样需要保证每层的特征图为正值,也就是说这个反激活过程和激活过程没有什么差别,都是直接采用 ReLU 函数。

2.3 Filtering

卷积过程使用学习到的过滤器对 feature map 进行卷积,为近似反转这个过程,反卷积使用该卷积核的转置来进行卷积操作。

注意:在上述重构过程中没有使用任何对比度归一化操作

3. Feature Visualization

在 ImageNet 验证集上使用反卷积进行特征图的可视化,如下图:

对于一个给定的 feature map,展示了响应最大的九张响应图,每个响应图向下映射到原图像素空间,右面的原图通过找到在原图的感受野来截取对应的原图。

通过观察可以发现,来自每个层中的投影显示出网络中特征的分层特性。第二层响应角落和其他的边缘/颜色信息,层三具有更复杂的不变性,捕获相似的纹理,层四显示了显著的变化,并且更加类别具体化,层五则显示了具有显著姿态变化的整个对象,所以这就是常说的 CNN 结构前几层通常学习简单的线条纹理,一些共性特征,后面将这些特征组合成 不同的更丰富的语义内容。

4. Feature Evolution during Training

文中对于一个 layer 中给定的 feature map,图中给出在训练 epochs 在 [1,2,5,10,20,30,40,64]时,训练集对该 feature map 响应最大的可视化图片,如下图:

从图中可以看出,较低层 (L1, L2) 只需要几个 epochs 就可以完全收敛,而高层 (L5) 则需要很多次迭代,需要让模型完全收敛之后。这一点正好与深层网络的梯度弥散现象正好相反,但是这种底层先收敛,然后高层再收敛的现象也很符合直观。

5. Feature Invariance

上图显示出了相对于未变换的特征,通过垂直平移,旋转和缩放的 5 个样本图像在可视化过程中的变化。小变换对模型的第一层有着显著的影响,但对顶层影响较小,对于平移和缩放是准线性的。网络输出对于平移和缩放是稳定的。但是一般来说,除了具有旋转对称性的物体来说,输出来旋转来说是不稳定的(这说明了卷积操作对于平移和缩放具有很好的不变性,而对于旋转的不变性较差)。

6. ZF Net

可视化训练模型不但可以洞察 CNN 的操作,也可以帮助我们在前几层选择更好的模型架构。通过可视化 AlexNet 的前两层(图中b,d),就可以看出问题:

- 第一层 filter 是非常高频和低频的信息,中间频率的filter很少覆盖

- 第二层的可视化有些具有混叠效应,由于第一层比较大的 stride

为了解决这些问题:

将第一层的 filter 的尺寸从

11x11减到7x7缩小间隔,从

4变为2。

这两个改动形成的新结构,获取了更多的信息,而且提升了分类准确率。

7. 实验

首先,作者进行了网络结构尺寸调整实验。去除掉包含大部分网络参数最后两个全连接层之后,网络性能下降很少;去掉中间两层卷积层之后,网络性能下降也很少;但是当把上述的全连接层和卷积层都去掉之后,网络性能急剧下降,由此作者得出结论:模型深度对于模型性能很重要,存在一个最小深度,当小于此深度时,模型性能大幅下降。

作者固定了通过 ImageNet pre-train 网络的权值,只是使用新数据训练了 softmax 分类器,效果非常好。这就形成了目前的人们对于卷积神经网络的共识:卷积网络相当于一个特征提取器。特征提取器是通用的,因为 ImageNet 数据量,类别多,所以由 ImageNet 训练出来的特征提取器更具有普遍性。也正是因为此,目前的卷积神经网络的 Backbone Network 基本上都是 ImageNet 上训练出来的网络。

总结

本文最大的贡献在于通过使用可视化技术揭示了神经网络各层到底在干什么,起到了什么作用。可视化技术依赖于反卷积操作,即卷积的逆过程,将特征映射到像素上。具体过程如下图所示:

- Unpooling:在卷积神经网络中,最大池化是不可逆的,作者采用近似的实现,使用一组转换变量 switch 记录每个池化区域最大值的位置。在反池化的时候,将最大值返回到其所应该在的位置,其他位置用

0补充。 - Rectification:反卷积的时候也同样利用 ReLU 激活函数

- Filtering:解卷积网络中利用卷积网络中相同的 filter 的转置应用到 Rectified Unpooled Maps,也就是对 filter 进行水平方向和垂直方向的翻转。

可视化不仅能够看到一个训练完的模型的内部操作,而且还能够帮助改进网络结构从而提高网络性能。ZF Net 模型是在 AlexNet 基础上进行改动,网络结构上并没有太大的突破。差异表现在,AlexNet 是用两块 GPU 的稀疏连接结构,而 ZF Net 只用了一块 GPU 的稠密链接结构;改变了 AlexNet 的第一层,将过滤器的大小由 11x 11 变成 7x7,并且将步长由 4 变成 2 ,使用更小的卷积核和步长,保留更多特征;将3,4,5 层变成了全连接。

VGG Net

出自论文 《Very Deep Convolutional Networks for Large-Scale Image Recognition》

1. 概括

VGG 模型由牛津大学 VGG 组提出。VGG 全部使用了 3x3 的卷积核和 2x2 最大池化核通过不断加深网络结构来提神性能。采用堆积的小卷积核优于采用大的卷积核,因为多层非线性层可以增加网络深层来保证学习更复杂的模式,而且所需的参数还比较少。

VGG 论文给出了一个非常振奋人心的结论:卷积神经网络的深度增加和小卷积核的使用对网络的最终分类识别效果有很大的作用。

2. 创新点

VGG 全部使用 3x3 的卷积核和 2x2 的池化核,通过不断加深网络结构来提升性能。网络层数的增长并不会带来参数量上的爆炸,因为参数量主要集中在最后三个全连接层中。同时,两个 3x3 卷积层的串联相当于 1 个 5x5 的卷积层(在像素关联性上,两个 3x3 的卷积可连接到范围与一个 5x5 卷积可连接到的范围相当),3 个 3x3 的卷积层串联相当于 1 个 7x7 的卷积层,即 3 个 3x3 卷积层的感受野大小相当于 1 个 7x7 的卷积层。但是 3 个 3x3 的卷积层参数量只有 7x7 的一半左右,同时前者可以有 3 个非线性操作,而后者只有 1 个非线性操作,这样使得前者对于特征的学习能力更强。

使用 1x1 的卷积层来增加线性变换,输出的通道数量上并没有发生改变。这里提一下 1x1 卷积层的其他用法,1x1 的卷积层常被用来提炼特征,即多通道的特征组合在一起,凝练成较大通道或者较小通道的输出,而每张图片的大小不变。有时 1x1 的卷积神经网络还可以用来替代全连接层。

VGG 在训练的时候先训级别 A 的简单网络,再复用 A 网络的权重来初始化后面的几个复杂模型,这样收敛速度更快。VGG 作者总结出 LRN 层作用不大,越深的网络效果越好,1x1 的卷积也是很有效的,但是没有 3x3 的卷积效果好,因为 3x3 的网络可以学习到更大的空间特征。

3. VGG 网路结构:

网络的输入为 224x224的 RGB 图片,后面跟卷积层,卷积核的大小基本都为 3x3 ,这一种最小的、可以保留图片空间分辨率的卷积核,步长为 1 个像素,偶尔会有 1x1 的卷积核,这就相当于加入了一个非线性变换而已。再往后接 pooling 层,它的大小为 2x2,步长为 2 个像素,并且采用 max pooling 的方法;再往后就是三层的全连层,第一层为 4096 个单元,第二层为 4096 个单元,第三层为 1000 个单元,即对应 1000 个类别,根据这 1000 个单元的输出其实这样就可以分类了;再往后为一个 softmax 层,目的其实就是用于计算网络的代价函数时用于求误差。

VGG 的网络结构如下图所示。VGG 包含很多级别的网络,深度从 11 层到 19 层不等,比较常用的是 VGG-16 和 VGG-19。VGG 把网络分成了 5 段,每段都把多个 3x3 的卷积网络串联在一起,每段卷积后面接一个最大池化层,最后面是 3 个全连接层和一个 softmax 层。

在上图中,如网络中的 conv3-512,表示网络的卷积核的大小为 3x3, 共有 512 个 feature map。另外,max pool 的具体配置没有写出来。

VGG 网络参数( 下图是整个模型的参数总量,单位是 millions,参数来自卷积层和全连接层,主要是全连接层):

- 两个堆叠的卷积层(卷积核为

3x3)有限感受野是5x5,三个堆叠的卷积层(卷积核为3x3)的感受野为7x7,故可以堆叠含有小尺寸卷积核的卷积层来代替具有大尺寸的卷积核的卷积层,并且能够使得感受野大小不变,而且多个3x3的卷积核比一个大尺寸卷积核有更多的非线性(每个堆叠的卷积层中都包含激活函数),使得 decision function更加具有判别性。 - 假设一个

3层的3x3卷积层的输入和输出都有Cchannels,堆叠的卷积层的参数个数为,而等同的一个单层的

7x7卷积层的参数为

可以看到 VGG-D 使用了一种块结构:多次重复使用统一大小的卷积核来提取更复杂和更具有表达性的特征。VGG 系列中,最多使用是 VGG-16,下图来自 Andrew Ng 深度学习里面对 VGG-16 架构的描述。如图所示,在 VGG-16 的第三、四、五块:256、512、512 个过滤器依次用来提取复杂的特征,其效果就等于一个带有3各卷积层的大型 512x512 大分类器。

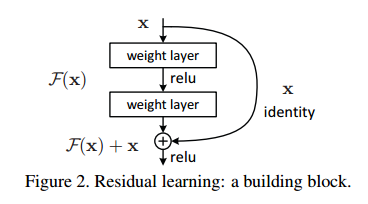

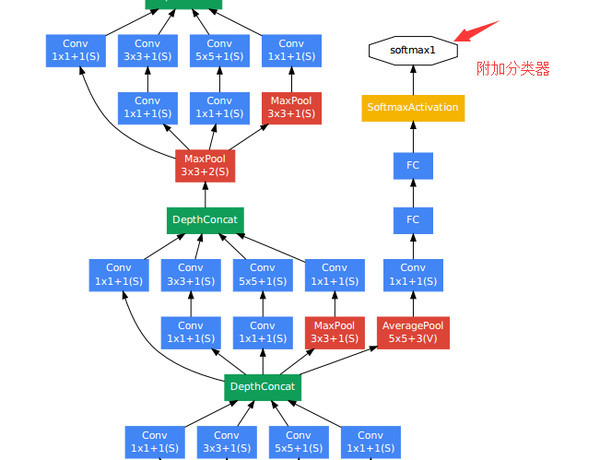

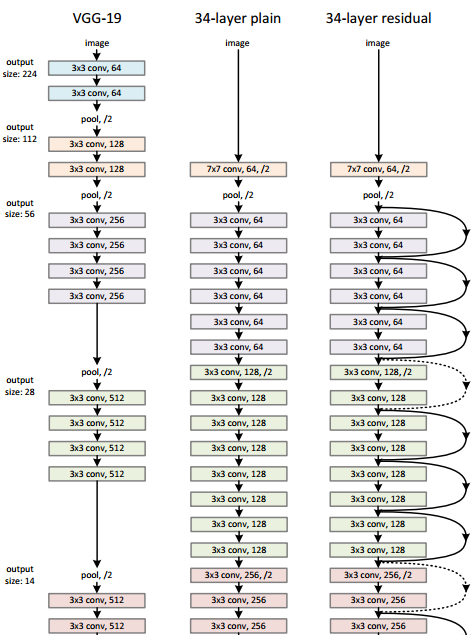

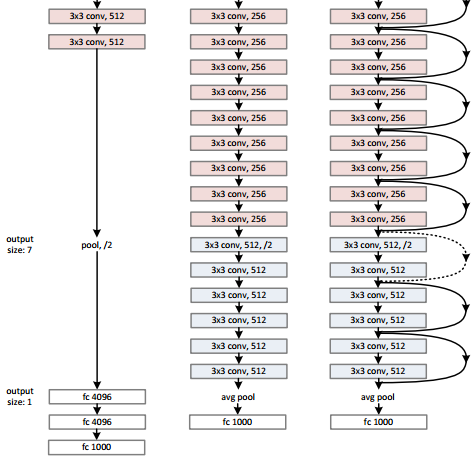

4. 训练